Apakah Facebook memiliki pusat data sendiri

Apakah Facebook memiliki pusat datanya sendiri?

Ringkasan:

Meta (sebelumnya Facebook) saat ini memiliki 47 pusat data yang sedang dibangun, dengan rencana untuk memiliki lebih dari 70 bangunan dalam waktu dekat. Ini mencerminkan ekspansi infrastruktur global perusahaan, dengan 18 kampus pusat data di seluruh dunia dengan total 40 juta kaki persegi. Terlepas dari tantangan yang ditimbulkan oleh gangguan pandemi dan rantai pasokan, Meta berharap untuk berinvestasi antara $ 29 miliar dan $ 34 miliar dalam pengeluaran modal pada tahun 2022.

Poin -Poin Kunci:

- Meta memiliki 47 pusat data yang sedang dibangun dan rencana untuk lebih dari 70 bangunan dalam waktu dekat.

- Perusahaan ini memiliki 18 kampus pusat data di seluruh dunia.

- Ekspansi selama gangguan pandemi dan rantai pasokan menantang.

- Meta mengharapkan untuk berinvestasi antara $ 29 miliar dan $ 34 miliar dalam pengeluaran modal pada tahun 2022.

- Operator Hyperscale Seperti Meta dan Microsoft menuangkan miliaran untuk memperluas infrastruktur pusat data mereka.

- Open Compute Project, didirikan oleh Facebook, mendorong inovasi dalam perangkat keras.

- Konstruksi pusat data membutuhkan pemilihan lokasi yang fleksibel dan proses konstruksi.

- Meta terlihat kepada vendor dan kontraktor sebagai mitra dalam mendorong praktik terbaik dan peningkatan berkelanjutan.

- Meta dan operator hiperskal lainnya sedang memelopori strategi baru untuk memberikan skala dan kecepatan.

- Skala dan tantangan program pusat data adalah kekuatan pendorong untuk meta.

Pertanyaan:

- Apa status konstruksi pusat data meta saat ini?

- Berapa banyak kampus pusat data yang dimiliki meta di seluruh dunia?

- Tantangan apa yang dihadapi meta dalam ekspansi pusat data?

- Berapa meta berencana untuk berinvestasi dalam pengeluaran modal pada tahun 2022?

- Perusahaan mana yang juga berinvestasi dalam ekspansi infrastruktur pusat data?

- Apa peran proyek komputasi terbuka?

- Faktor apa yang penting dalam konstruksi pusat data?

- Bagaimana vendor dan kontraktor Meta View?

- Strategi apa yang meta dan operator hiperskal lainnya perintis?

- Apa yang mendorong program pusat data meta?

Meta saat ini memiliki 47 pusat data yang sedang dibangun, dengan rencana lebih dari 70 bangunan dalam waktu dekat.

Meta memiliki 18 kampus pusat data di seluruh dunia.

Ekspansi pusat data selama gangguan pandemi dan rantai pasokan menimbulkan tantangan untuk meta.

Meta mengharapkan untuk berinvestasi antara $ 29 miliar dan $ 34 miliar dalam pengeluaran modal pada tahun 2022.

Operator Hyperscale seperti Microsoft juga menginvestasikan miliaran dalam memperluas infrastruktur pusat data mereka.

Proyek Komput Open, didirikan oleh Facebook, mendorong inovasi dalam perangkat keras.

Konstruksi pusat data membutuhkan pemilihan lokasi yang fleksibel dan proses konstruksi.

Meta melihat vendor dan kontraktor sebagai mitra dalam mendorong praktik terbaik dan peningkatan berkelanjutan.

Meta dan operator hiperskal lainnya sedang memelopori strategi baru untuk memberikan skala dan kecepatan.

Skala dan tantangan program pusat data adalah kekuatan pendorong untuk meta.

Apakah Facebook memiliki pusat data sendiri

Apa lagi yang ditelusuri Facebook? Frankovsky mengatakan bahwa “banyak motherboard hari ini datang dengan banyak manajemen Goop. Itulah istilah teknis yang ingin saya gunakan untuk itu.”Goop ini bisa menjadi mesin manajemen siklus hidup terintegrasi HP atau alat manajemen server jarak jauh Dell.

Facebook memiliki 47 pusat data yang sedang dibangun

Meta saat ini memiliki 47 pusat data yang sedang dibangun, kata perusahaan minggu ini, mencerminkan ruang lingkup luar biasa dari perluasan dunia yang sedang berlangsung’S Infrastruktur Digital.

Dia’S pernyataan singkat, jauh di dalam ulasan panjang inovasi di Facebook’S Infrastruktur Digital. Tetapi bagi siapa saja yang tahu industri pusat data, itu’S pembuka mata yang nyata.

“Seperti saya’m Menulis ini, kami memiliki 48 bangunan aktif dan 47 bangunan lainnya yang sedang dibangun,” kata Tom Furlong, presiden infrastruktur, pusat data di meta (sebelumnya Facebook). “Jadi kami’akan memiliki lebih dari 70 bangunan dalam waktu dekat.”

Pernyataan itu mencerminkan ruang lingkup meta yang luar biasa’S Global Infrastructure Expansion. Perusahaan ini memiliki 18 kampus pusat data di seluruh dunia, yang setelah selesai akan menjangkau 40 juta kaki persegi ruang pusat data.

Memiliki 47 bangunan yang sedang dibangun akan menjadi tantangan dalam keadaan apa pun, tetapi khususnya selama gangguan pandemi dan rantai pasokan global. Dia’S tidak mudah, atau murah. Meta mengatakan mereka mengharapkan untuk berinvestasi antara $ 29 miliar dan $ 34 miliar dalam pengeluaran modal pada tahun 2022, naik dari $ 19 miliar tahun lalu.

Dia’s tidak sendiri, karena operator hiperskal terbesar menuangkan miliaran dolar untuk memperluas infrastruktur pusat data mereka untuk memenuhi permintaan layanan digital mereka. Pengeluaran modal hyperscale naik 30 persen pada paruh pertama tahun 2021, menurut analisis dari Synergy Research Group, yang melacak 19 penyedia hyperscale yang menghabiskan sekitar $ 83 miliar dalam periode enam bulan.

Tingkat pengeluaran tersebut dapat dengan mudah meningkat, mengingat Facebook’Proyeksi tentang pengeluaran Capex di masa depan dan Microsoft’S berencana untuk membangun 50 hingga 100 pusat data setahun.

Inovasi infrastruktur pada skala epik

Furlong’Posting blog tentang meta’Perjalanan Pusat Data S bermanfaat untuk dibaca, seperti halnya pos pendamping yang melihat kembali kemajuan proyek komputasi terbuka, inisiatif perangkat keras terbuka yang didirikan oleh Facebook pada tahun 2011.

“Open Hardware mendorong inovasi, dan bekerja dengan lebih banyak vendor berarti lebih banyak kesempatan untuk mengembangkan perangkat keras generasi berikutnya untuk mendukung fitur saat ini dan yang muncul di seluruh meta’S Family of Technologies.,” Furlong menulis.

Kebutuhan untuk berinovasi pada skala juga termasuk konstruksi pusat data.

“Ada banyak aktivitas di pusat data dan industri konstruksi saat ini, yang memberi tekanan pada kami untuk menemukan situs dan mitra yang tepat,” kata furlong. “Ini juga berarti kita perlu membuat pemilihan situs yang lebih fleksibel dan proses konstruksi. Semua upaya ini juga melibatkan melihat vendor dan kontraktor kami lebih sebagai mitra dalam semua ini. Kita dapat’t hanya membuat ini tentang dolar. Kita harus membuatnya tentang kinerja. Kita harus membuatnya tentang mendorong praktik terbaik dan peningkatan berkelanjutan.

“Tapi itu’Bukankah cara industri konstruksi biasanya bekerja,” dia melanjutkan. “Jadi, kami’ve harus membawa banyak ide kami sendiri tentang menjalankan operasi dan membuat perbaikan dan mengesankannya pada perusahaan tempat kami bekerja.”

Infrastruktur digital menjadi lebih penting setiap hari, dan meta dan rekan -rekannya yang hyperscale memelopori strategi baru untuk memberikan skala dan kecepatan yang mereka butuhkan. Dia’s Proses yang berkelanjutan, seperti yang direfleksikan Furlong.

“Pindah ke arena pusat data tidak akan pernah mudah,” dia menulis. “Tapi saya pikir kami’VE berakhir dengan program yang luar biasa dalam skala yang tidak pernah saya bayangkan. Dan kita’selalu diminta untuk berbuat lebih banyak. Itu’s tantangan bisnis, dan itu’mungkin salah satu hal utama yang membuat saya dan tim saya datang untuk bekerja setiap hari. Kami memiliki tantangan besar di depan kami untuk melakukan sesuatu yang sangat besar dalam skala.”

Apakah Facebook memiliki pusat data sendiri

Kembali ke Blog Home

с 20 2016

Infrastruktur Facebook: Strategi dan Pengembangan Pusat Data Dalam

Oleh meta karier

Rachel Peterson memimpin tim strategi pusat data infrastruktur Facebook. Timnya mengelola portofolio pusat data Facebook dan memberikan dukungan strategis untuk mengidentifikasi peluang untuk keberlanjutan, efisiensi, dan keandalan infrastruktur lebih lanjut. Lihatlah pengalamannya di Facebook, dan bagaimana timnya berupaya menghubungkan dunia.

Apa cerita Facebook Anda?

Saya bergabung dengan Facebook pada tahun 2009 ketika perusahaan baru saja akan meluncurkan pusat data pertamanya di Prineville, Oregon. Pada saat itu, seluruh tim pusat data terdiri dari kurang dari 30 anggota tim dan Facebook menempati dua jejak kaki kecil di AS. Saya bergabung untuk membantu membangun program pemilihan situs untuk pusat data yang dimiliki Facebook. Hari ini, tim kami terdiri lebih dari 100 orang di berbagai lokasi di seluruh dunia.

Maju cepat ke hari ini, Facebook sekarang memiliki dan mengoperasikan portofolio besar pusat data, yang mencakup AS, Eropa dan Asia. Program pemilihan situs telah berhasil meluncurkan lima belas pusat data besar -besaran, dan kami berkomitmen untuk memberi daya pada pusat data ini dengan 100% energi terbarukan. Pada 2012, kami menetapkan tujuan pertama kami dari 25% energi bersih dan terbarukan dalam campuran pasokan listrik kami pada tahun 2015 untuk semua pusat data. Pada 2017, kami melampaui 50% energi bersih dan terbarukan untuk semua operasi Facebook. Pada tahun 2018, kami menetapkan target agresif kami berikutnya – bertujuan untuk memenuhi energi bersih dan terbarukan 100% untuk semua operasi Facebook yang berkembang pada akhir tahun 2020.

Sangat menyenangkan berada di garis depan pertumbuhan ini, dan membangun tim yang telah memainkan peran penting dalam menumbuhkan infrastruktur Facebook. Tidak pernah ada momen yang membosankan dalam perjalanan yang luar biasa ini! Pertumbuhan Facebook telah membuatnya menantang dan menyenangkan, dan saya tidak berpikir suatu hari telah berlalu di tempat saya belum belajar. Saya suka apa yang saya lakukan, dan saya benar -benar beruntung bekerja dengan tim yang luar biasa dan menyenangkan. Budaya Facebook memberdayakan tim saya untuk memiliki dampak yang luas, dan bersama-sama kami membuat dunia lebih terbuka dan terhubung. satu pusat data sekaligus.

Misi Facebook adalah membuat dunia lebih terbuka dan terhubung, peran apa yang dimiliki tim Anda dalam hal ini?

Memimpin Strategi Lokasi Global Facebook dan Upaya Pemilihan Lokasi Berdasarkan Sejumlah Kriteria Situs Kritis, Termasuk Energi Terbarukan Baru Untuk Mendukung Situs.

Mengelola program kepatuhan lingkungan global Facebook, dari pemilihan lokasi di seluruh operasi, termasuk kepatuhan udara dan air.

Memimpin program energi global Facebook, dari pemilihan lokasi di seluruh operasi, mengoptimalkan pasokan energi untuk 100% energi terbarukan, sambil memastikan tanggung jawab dan keandalan fiskal.

Memimpin perencanaan strategis, memungkinkan, dan memantau peta jalan pusat data global.

Memberikan dukungan ilmu data untuk memungkinkan keputusan strategis dan optimasi kinerja di seluruh siklus hidup pusat data.

Memimpin pekerjaan keterlibatan komunitas kami di lokasi di mana kami memiliki pusat data.

Mengembangkan dan mengelola strategi kebijakan dan risiko mitigasi untuk memungkinkan perluasan global Facebook’Jejak Infrastruktur S.

Facebook berkomitmen untuk menjadi kekuatan untuk kebaikan di mana pun kami bekerja dengan menyediakan pekerjaan, menumbuhkan ekonomi, dan program pendukung yang menguntungkan komunitas tempat kami tinggal.

Tim keberlanjutan kami’S misi adalah untuk mendukung Facebook’S Kemampuan untuk beroperasi dan tumbuh secara efisien dan bertanggung jawab dan memberdayakan orang untuk membangun komunitas yang berkelanjutan.

Memimpin strategi di seluruh perusahaan dalam mendorong keunggulan operasional dari desain, konstruksi, dan operasi bisnis kami. Kami memprioritaskan efisiensi, konservasi air, dan keunggulan rantai pasokan dan bangga mengatakan fasilitas kami adalah yang paling hemat air dan energi di dunia.

Kami berkomitmen untuk melawan perubahan iklim dan telah menetapkan target berbasis sains untuk mengurangi emisi kami sebesar 75 persen pada tahun 2020.

Nilai -nilai inti Facebook bergerak cepat, fokus pada dampak, membangun nilai sosial, terbuka, berani. Nilai mana yang benar -benar beresonansi dengan tim Anda?

Fokus pada dampak. Tim kami relatif ramping dan kami memiliki kemampuan untuk memberikan banyak inisiatif dampak tinggi untuk perusahaan.

Apa sesuatu yang kebanyakan orang tidak tahu tentang tim Anda?

Kami memiliki tim yang sangat beragam yang terdiri dari pengacara, manajer kebijakan publik, analis keuangan, manajer program, ilmuwan data, profesional energi, insinyur, dan pakar proses bisnis.

Dapatkah Anda berbagi tentang menjadi pemimpin wanita di industri teknologi dan pentingnya keragaman di Facebook dan teknologi pada umumnya?

Salah satu alasan mengapa saya suka bekerja di facebook adalah komitmen kami terhadap keragaman. Keragaman bukanlah kegiatan ekstrakurikuler di Facebook, melainkan sesuatu yang ingin kami terapkan di semua tingkatan perusahaan. Meskipun kami, dan industri teknologi secara keseluruhan, memiliki lebih banyak pekerjaan yang harus dilakukan di sini, kami terus memperkuat komitmen ini melalui budaya kami, produk kami, dan prioritas perekrutan kami.

Sebagai seorang wanita di bidang teknologi, saya tahu secara langsung betapa pentingnya keragaman bagi industri kami dan betapa beragamnya perspektif mendorong hasil yang lebih baik. Sangat penting bagi kami untuk melakukan segala yang kami bisa untuk meningkatkan perekrutan kandidat yang beragam dan untuk mendorong perempuan untuk bergabung dengan sektor -sektor yang biasanya didominasi laki -laki. Saya menemukan karier saya memanggil dalam pemilihan situs real estat, industri yang didominasi pria tradisional, dan saya menemukan inspirasi saya melalui banyak wanita berbakat yang menginspirasi dan membimbing saya di sepanjang jalan. Hari ini, sebagai pemimpin wanita di bidang teknologi, adalah tugas dan hak istimewa saya untuk menjadi mentor bagi wanita, dan melakukan apa yang saya bisa untuk secara aktif mendukung pertumbuhan dan kemajuan perempuan di industri ini.

Saran saya untuk wanita? Temukan gairah Anda dan ikuti mereka, bahkan jika Anda akhirnya berada di area tempat Anda’biasanya biasanya satu -satunya wanita di ruangan itu. Kekuatan Anda akan berkembang melalui gairah Anda, dan Anda’ll bekerja lebih keras pada kerajinan Anda. Karier Anda akan menemukan lintasannya sendiri. Yang terpenting, biarkan diri Anda beberapa ruang gagal, dan segera kembali jika Anda tersandung di sepanjang jalan.

Apakah Facebook memiliki pusat data sendiri

Facebook’S Layanan mengandalkan armada server di pusat data di seluruh dunia – semua aplikasi yang berjalan dan memberikan kinerja yang dibutuhkan layanan kami. Inilah sebabnya mengapa kami perlu memastikan perangkat keras server kami dapat diandalkan dan bahwa kami dapat mengelola kegagalan perangkat keras server pada skala kami dengan sedikit gangguan pada layanan kami.

Komponen perangkat keras sendiri dapat gagal karena sejumlah alasan, termasuk degradasi material (e.G., Komponen mekanis dari drive hard disk pemintalan), perangkat yang digunakan di luar tingkat ketahanannya (e.G., NAND Flash Devices), Dampak Lingkungan (E.G., korosi karena kelembaban), dan cacat manufaktur.

Secara umum, kami selalu mengharapkan beberapa tingkat kegagalan perangkat keras di pusat data kami, itulah sebabnya kami menerapkan sistem seperti sistem manajemen cluster kami untuk meminimalkan gangguan layanan. Dalam artikel ini kami’memperkenalkan empat metodologi penting yang membantu kami mempertahankan ketersediaan perangkat keras tingkat tinggi. Kami memiliki sistem membangun yang dapat mendeteksi dan memulihkan masalah . Kami memantau dan memulihkan peristiwa perangkat keras tanpa berdampak buruk pada kinerja aplikasi . Kami mengadopsi pendekatan proaktif untuk perbaikan perangkat keras dan menggunakan metodologi prediksi untuk remediasi . Dan kami mengotomatiskan analisis akar penyebab untuk kegagalan perangkat keras dan sistem pada skala untuk mencapai bagian bawah masalah dengan cepat.

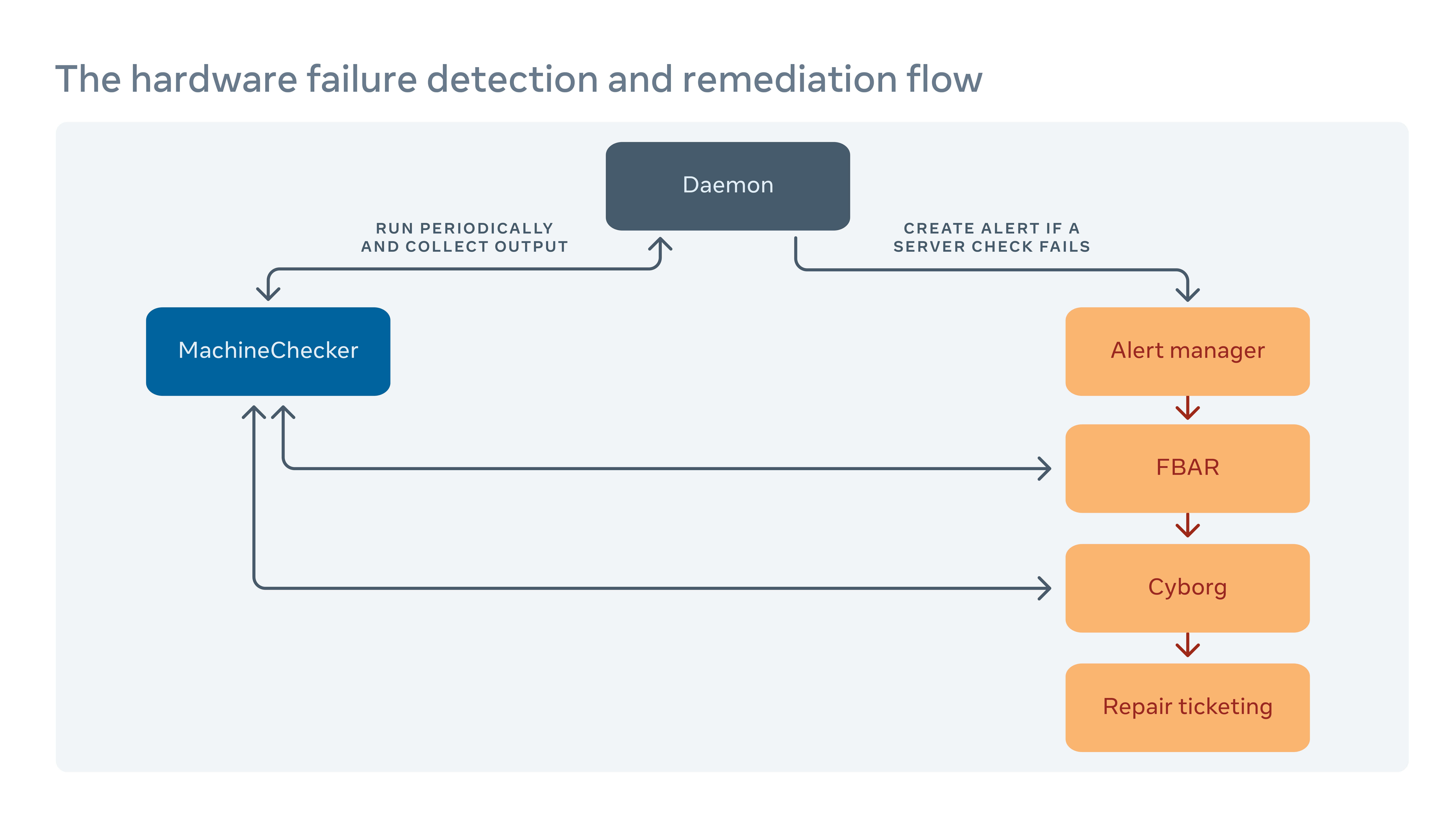

Bagaimana kami menangani remediasi perangkat keras

Kami secara berkala menjalankan alat yang disebut Machinechecker di setiap server untuk mendeteksi kegagalan perangkat keras dan konektivitas. Setelah Machinechecker membuat peringatan di sistem penanganan peringatan yang terpusat, alat yang disebut Facebook Auto-Remediation (FBAR) kemudian mengambil peringatan dan menjalankan remediasi yang dapat disesuaikan untuk memperbaiki kesalahan. Untuk memastikan bahwa di sana’S lebih banyak kapasitas untuk Facebook’S Layanan, kami juga dapat menetapkan batas tarif untuk membatasi berapa banyak server yang sedang diperbaiki pada satu waktu.

Jika fbar bisa’t membawa server kembali ke keadaan sehat, kegagalan diteruskan ke alat yang disebut cyborg. Cyborg dapat menjalankan remediasi tingkat rendah seperti peningkatan firmware atau kernel, dan reimaging. Jika masalah membutuhkan perbaikan manual dari teknisi, sistem membuat tiket di sistem tiket perbaikan kami.

Kami menggali lebih dalam proses ini di makalah kami “Remediasi perangkat keras pada skala.”

Bagaimana kami meminimalkan dampak negatif dari pelaporan kesalahan pada kinerja server

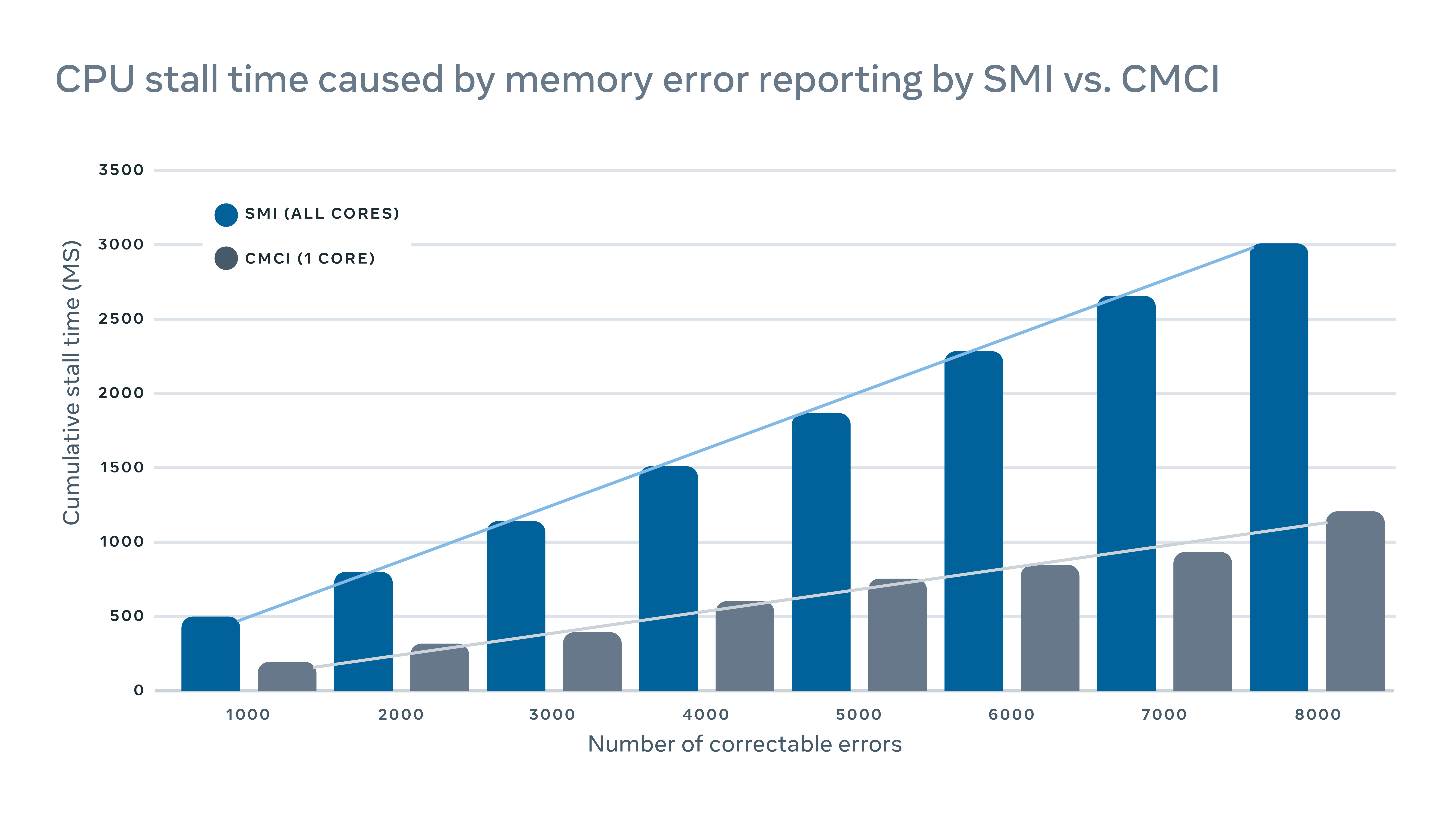

Machinechecker mendeteksi kegagalan perangkat keras dengan memeriksa berbagai log server untuk laporan kesalahan. Biasanya, ketika kesalahan perangkat keras terjadi, itu akan terdeteksi oleh sistem (e.G., gagal pemeriksaan paritas), dan sinyal interupsi akan dikirim ke CPU untuk menangani dan mencatat kesalahan.

Karena sinyal interupsi ini dianggap sebagai sinyal prioritas tinggi, CPU akan menghentikan operasi normal dan mencurahkan perhatiannya untuk menangani kesalahan. Tapi ini memiliki dampak kinerja negatif di server. Untuk logging kesalahan memori yang dapat diperbaiki, misalnya, interupsi manajemen sistem interupsi tradisional (SMI) akan menghentikan semua inti CPU, sedangkan mesin pemeriksaan yang dapat dikoreksi (CMCI) hanya akan menghentikan salah satu inti CPU, meninggalkan sisa inti CPU yang tersedia untuk operasi normal yang normal.

Meskipun kios CPU biasanya hanya bertahan beberapa ratus milidetik, mereka masih dapat mengganggu layanan yang sensitif terhadap latensi. Dalam skala, ini berarti interupsi pada beberapa mesin dapat memiliki dampak buruk yang mengalir pada kinerja tingkat layanan.

Untuk meminimalkan dampak kinerja yang disebabkan oleh pelaporan kesalahan, kami menerapkan mekanisme hybrid untuk pelaporan kesalahan memori yang menggunakan CMCI dan SMI tanpa kehilangan keakuratan dalam hal jumlah kesalahan memori yang dapat diperbaiki.

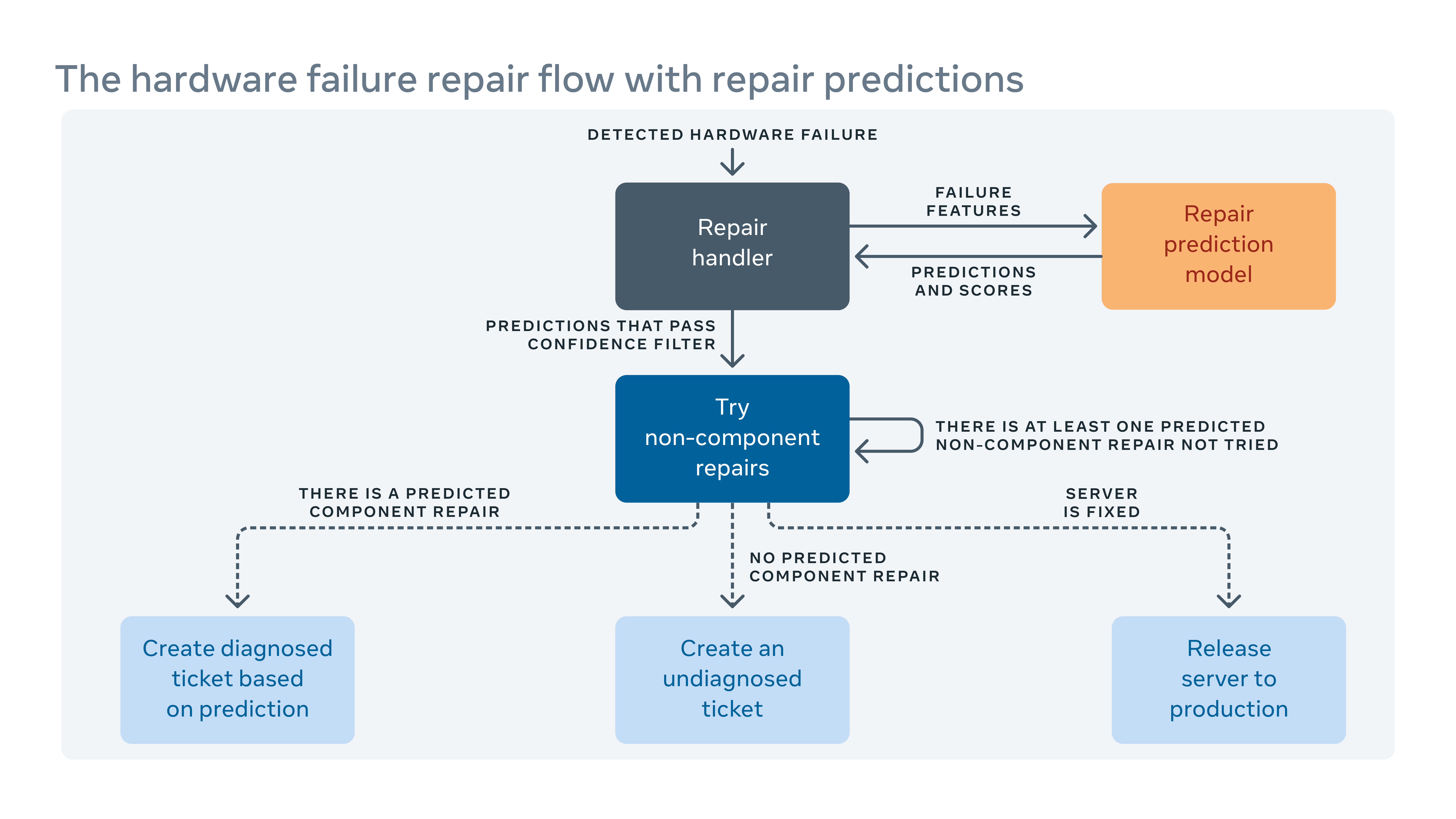

Bagaimana kami memanfaatkan pembelajaran mesin untuk memprediksi perbaikan

Karena kami sering memperkenalkan konfigurasi perangkat keras dan perangkat lunak baru ke pusat data kami, kami juga perlu membuat aturan baru untuk sistem remediasi otomatis kami.

Ketika sistem otomatis tidak dapat memperbaiki kegagalan perangkat keras, masalah tersebut diberi tiket untuk perbaikan manual. Perangkat Keras dan Perangkat Lunak Baru berarti jenis baru dari potensi kegagalan yang harus ditangani. Tetapi mungkin ada kesenjangan antara ketika perangkat keras atau perangkat lunak baru diimplementasikan dan ketika kami dapat memasukkan aturan remediasi baru. Selama celah ini, beberapa tiket perbaikan mungkin diklasifikasikan sebagai “tidak terdiagnosis,” artinya sistemnya tidak ada’t menyarankan tindakan perbaikan, atau “salah didiagnosis,” artinya tindakan perbaikan yang disarankan adalah’t efektif. Ini berarti lebih banyak waktu luang tenaga kerja dan sistem sementara teknisi harus mendiagnosis masalah ini sendiri.

Untuk menutup celah, kami membangun kerangka kerja pembelajaran mesin yang belajar dari bagaimana kegagalan telah diperbaiki di masa lalu dan mencoba memprediksi perbaikan apa yang diperlukan untuk tiket perbaikan yang tidak terdiagnosis dan salah didiagnosis saat ini. Berdasarkan biaya dan manfaat dari prediksi yang salah dan benar, kami menetapkan ambang batas pada kepercayaan prediksi untuk setiap tindakan perbaikan dan mengoptimalkan urutan tindakan perbaikan. Misalnya, dalam beberapa kasus kami lebih suka mencoba reboot atau peningkatan firmware terlebih dahulu karena perbaikan semacam ini tidak’t membutuhkan perbaikan perangkat keras fisik dan membutuhkan waktu lebih sedikit untuk menyelesaikannya, jadi algoritma harus merekomendasikan tindakan semacam ini terlebih dahulu. Jelas, pembelajaran mesin memungkinkan kita tidak hanya untuk memprediksi cara memperbaiki masalah yang tidak terdiagnosis atau salah didiagnosis, tetapi juga untuk memprioritaskan yang paling penting.

Bagaimana kita’Analisis Penyebab Akar Tingkat Armada Otomatis

Selain log server yang merekam reboot, kernel panik di luar memori, dll., Ada juga perangkat lunak dan log alat di sistem produksi kami. Tetapi skala dan kompleksitas semua ini berarti’sulit untuk memeriksa semua log bersama -sama untuk menemukan korelasi di antara mereka.

Kami menerapkan alat analisis akar-analisis (RCA) yang dapat diskalakan yang memilah jutaan entri log (masing-masing dijelaskan oleh ratusan kolom) untuk menemukan korelasi yang mudah dipahami dan dapat ditindaklanjuti.

Dengan data pra-agregasi menggunakan scuba, database dalam memori realtime, kami secara signifikan meningkatkan skalabilitas algoritma penambangan pola tradisional, pertumbuhan FP, untuk menemukan korelasi dalam kerangka kerja RCA ini. Kami juga menambahkan satu set filter pada korelasi yang dilaporkan untuk meningkatkan interpretabilitas hasil. Kami telah menggunakan penganalisa ini secara luas di dalam Facebook untuk RCA pada tingkat kegagalan komponen perangkat keras, reboot server yang tidak terduga, dan kegagalan perangkat lunak.

Siapa yang membutuhkan HP dan Dell? Facebook sekarang merancang semua servernya sendiri

Pusat data terbaru Facebook tidak akan memiliki server OEM.

Jon Brodkin – 14 Feb 2013 10:35 PM UTC

Komentar Pembaca

Hampir dua tahun yang lalu, Facebook meluncurkan apa yang disebutnya proyek komputasi terbuka. Idenya adalah untuk berbagi desain untuk perangkat keras pusat data seperti server, penyimpanan, dan rak sehingga perusahaan dapat membangun peralatan mereka sendiri alih -alih mengandalkan opsi sempit yang disediakan oleh vendor perangkat keras.

Sementara siapa pun bisa mendapat manfaat, Facebook memimpin dalam menggunakan perangkat keras yang dibuat khusus di pusat datanya sendiri. Proyek ini sekarang telah maju ke titik di mana semua server baru yang digunakan oleh Facebook telah dirancang oleh Facebook itu sendiri atau dirancang oleh orang lain dengan spesifikasi Facebook yang menuntut. Perlengkapan khusus hari ini membutuhkan lebih dari setengah peralatan di pusat data Facebook. Selanjutnya, Facebook akan membuka pusat data seluas 290.000 kaki persegi di Swedia sepenuhnya dipenuhi dengan server desainnya sendiri, yang pertama untuk perusahaan.

“Ini yang pertama di mana kita akan memiliki server komputasi terbuka 100 persen di dalamnya,” Frank Frankovsky, VP desain perangkat keras dan operasi rantai pasokan di Facebook, mengatakan kepada ARS dalam sebuah wawancara telepon minggu ini.

Seperti pusat data Facebook yang ada di North Carolina dan Oregon, yang online musim panas ini di Luleå, Swedia akan memiliki puluhan ribu server. Facebook juga menempatkan perlengkapannya di ruang pusat data sewaan untuk mempertahankan kehadiran di dekat pengguna di seluruh dunia, termasuk di 11 lokasi colocation di AS. Berbagai faktor berkontribusi pada pilihan lokasi: pajak, tenaga kerja teknis yang tersedia, sumber dan biaya listrik, dan iklim. Facebook tidak menggunakan AC tradisional, alih -alih mengandalkan sepenuhnya “udara luar dan sistem pendingin evaporatif yang unik untuk menjaga server kami cukup keren,” kata Frankovsky.

Menghemat Uang Dengan Mengupas Apa yang Anda Don’t perlu

Pada skala Facebook, lebih murah untuk mempertahankan pusat datanya sendiri daripada mengandalkan penyedia layanan cloud, katanya. Selain itu, juga lebih murah bagi Facebook untuk menghindari vendor server tradisional.

Seperti Google, Facebook merancang servernya sendiri dan membuatnya dibangun oleh ODMS (produsen desain asli) di Taiwan dan Cina, bukan OEM (produsen peralatan asli) seperti HP atau Dell. Dengan menggulungnya sendiri, Facebook menghilangkan apa yang disebut Frankovsky “diferensiasi serampangan,” fitur perangkat keras yang membuat server unik tetapi tidak menguntungkan Facebook.

Ini bisa sesederhana bezel plastik di server dengan logo merek, karena sedikit material ekstra memaksa para penggemar untuk bekerja lebih keras. Frankovsky mengatakan sebuah penelitian menunjukkan server OEM berukuran 1U standar “menggunakan daya kipas 28 watt untuk menarik udara melalui impedansi yang disebabkan oleh bezel plastik itu,” sedangkan server komputasi terbuka yang setara hanya menggunakan tiga watt untuk tujuan itu.

Apa lagi yang ditelusuri Facebook? Frankovsky mengatakan bahwa “banyak motherboard hari ini datang dengan banyak manajemen Goop. Itulah istilah teknis yang ingin saya gunakan untuk itu.”Goop ini bisa menjadi mesin manajemen siklus hidup terintegrasi HP atau alat manajemen server jarak jauh Dell.

Fitur -fitur itu bisa berguna bagi banyak pelanggan, terutama jika mereka memiliki standar pada satu vendor. Tetapi pada ukuran Facebook, tidak masuk akal untuk hanya mengandalkan satu vendor, karena “kesalahan desain mungkin mengambil sebagian besar armada Anda atau karena kekurangan bagian dapat melumpuhkan kemampuan Anda untuk mengirimkan produk ke pusat data Anda.”

Facebook memiliki alat manajemen pusat data sendiri, jadi barang yang dibuat HP atau Dell tidak perlu. Produk vendor “Dilengkapi dengan set antarmuka pengguna sendiri, set API, dan GUI yang cantik untuk memberi tahu Anda seberapa cepat penggemar berputar dan beberapa hal yang secara umum sebagian besar pelanggan menggunakan hal -hal ini pada tampilan skala sebagai diferensiasi serampangan,” kata Frankovsky. “Ini berbeda dengan cara yang tidak masalah bagi saya. Instrumentasi tambahan di motherboard, tidak hanya membutuhkan biaya untuk membelinya dari perspektif material, tetapi juga menyebabkan kompleksitas dalam operasi.”

Jalur untuk HP dan Dell: beradaptasi dengan komputasi terbuka

Itu tidak berarti Facebook bersumpah HP dan Dell selamanya. “Sebagian besar perlengkapan baru kami dibangun oleh ODMS seperti Quanta,” kata perusahaan itu dalam respons email terhadap salah satu pertanyaan tindak lanjut kami. “Kami melakukan multi-sumber semua perlengkapan kami, dan jika OEM dapat membangun standar kami dan membawanya dalam 5 persen, maka mereka biasanya dalam diskusi multi-sumber tersebut.”

HP dan Dell telah mulai membuat desain yang sesuai dengan spesifikasi komputasi terbuka, dan Facebook mengatakan itu menguji satu dari HP untuk melihat apakah itu dapat membuat potongan. Perusahaan mengkonfirmasi, bahwa pusat data baru di Swedia tidak akan menyertakan server OEM ketika dibuka.

Facebook mengatakan itu mendapat penghematan keuangan 24 persen dari memiliki infrastruktur berbiaya lebih rendah, dan menghemat 38 persen dalam biaya operasional yang berkelanjutan sebagai akibat dari membangun barang-barangnya sendiri. Server yang dirancang khusus Facebook tidak menjalankan beban kerja yang berbeda dari server lainnya-mereka hanya menjalankannya lebih efisien.

“Server hp atau dell, atau server komputasi terbuka, mereka semua dapat menjalankan beban kerja yang sama,” kata Frankovsky. “Ini hanya masalah berapa banyak pekerjaan yang Anda lakukan per watt per dolar.”

Facebook tidak virtualisasi servernya, karena perangkat lunaknya sudah mengkonsumsi semua sumber daya perangkat keras, yang berarti virtualisasi akan menghasilkan hukuman kinerja tanpa keuntungan dalam efisiensi.

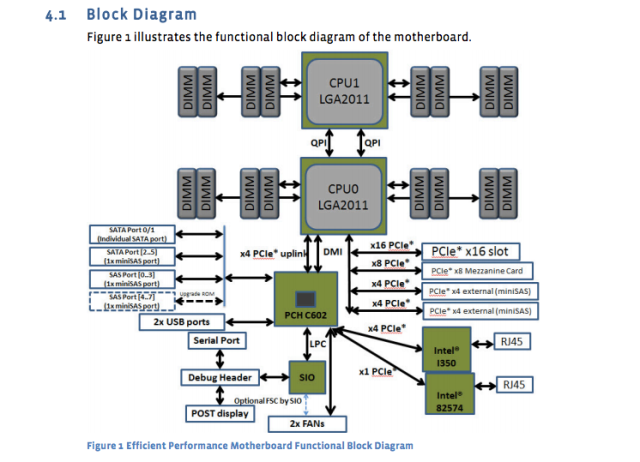

Raksasa media sosial telah menerbitkan desain dan spesifikasi servernya sendiri, motherboard, dan peralatan lainnya. Misalnya, motherboard “Windmill” menggunakan dua prosesor Intel Xeon E5-2600, dengan hingga delapan core per CPU.

Lembar spesifikasi Facebook memecahnya:

- 2 Prosesor Seri Intel® Xeon® E5-2600 (LGA2011) hingga 115W

- 2 Intel Full-Width Intel QuickPath Interconnect (QPI) menghubungkan hingga 8 GT/s/arah

- Hingga 8 core per CPU (hingga 16 utas dengan teknologi hiper-threading)

- Hingga 20 MB Cache Level Terakhir

- Mode prosesor tunggal

- DDR3 Dukungan memori terlampir langsung pada CPU0 dan CPU1 dengan:

- 4 saluran DDR3 Antarmuka memori terdaftar pada prosesor 0 dan 1

- 2 slot DDR3 per saluran per prosesor (total 16 dimm pada motherboard)

- RDIMM/LV-RDIMM (1.5V/1.35V), LRDIMM dan ECC UDIMM/LV-Udimm (1.5V/1.35v)

- DIMMS Single, Dual, dan Quad Ranks

- Kecepatan DDR3 800/1066/1333/1600 MHz

- Hingga maksimum 512 GB memori dengan 32GB RDIMM DIMMS

Dan sekarang diagram motherboard:

Spesifikasi motherboard itu diterbitkan hampir setahun yang lalu, tetapi mereka masih standar. Server database yang baru dirancang “Dragonstone” dan server web “Winterfell” mengandalkan motherboard windmill, meskipun Intel CPU yang lebih baru mungkin mencapai produksi di Facebook akhir tahun ini.

Desain server Facebook dirancang untuk berbagai tugas. Seperti yang dilaporkan oleh Timothy Prickett Morgan dari register bulan lalu, fungsi basis data tertentu di Facebook memerlukan catu daya yang berlebihan, sedangkan tugas lain dapat ditangani oleh server dengan beberapa node komputasi yang berbagi satu catu daya tunggal tunggal.

Pusat Data Gunakan campuran penyimpanan flash dan disk pemintalan tradisional, dengan flash melayani fungsionalitas Facebook yang membutuhkan kecepatan tercepat yang tersedia. Server database menggunakan semua flash. Server web biasanya memiliki CPU yang sangat cepat, dengan jumlah penyimpanan dan RAM yang relatif rendah. 16GB adalah jumlah ram khas, kata Frankovsky. Chip Intel dan AMD keduanya memiliki kehadiran di perlengkapan Facebook.

Dan Facebook dibebani dengan banyak “Cold Storage,” barang -barang yang ditulis sekali dan jarang diakses lagi. Bahkan di sana, Frankovsky ingin semakin menggunakan flash karena tingkat kegagalan disk pemintalan. Dengan puluhan ribu perangkat yang beroperasi, “Kami tidak ingin teknisi berlarian mengganti hard drive,” katanya.

Flash kelas pusat data biasanya jauh lebih mahal daripada disk pemintalan, tetapi Frankovsky mengatakan mungkin ada cara untuk membuatnya layak. “Jika Anda menggunakan kelas NAND [flash] dalam drive jempol, yang biasanya dianggap sapuan atau memo NAND, dan Anda menggunakan jenis algoritma pengontrol yang sangat keren untuk mengkarakterisasi sel mana yang baik dan sel mana yang tidak, Anda berpotensi membangun solusi penyimpanan dingin kinerja yang sangat tinggi dengan biaya yang sangat rendah,” katanya, “katanya,” katanya, “katanya,” katanya, “katanya sangat rendah,”.

Mengambil fleksibilitas pusat data ke ekstrem

Frankovsky menginginkan desain yang sangat fleksibel sehingga komponen individu dapat ditukar sebagai respons terhadap perubahan permintaan. Salah satu upaya di sepanjang garis itu adalah spesifikasi “grup pelukan” baru Facebook untuk motherboard, yang dapat mengakomodasi prosesor dari berbagai vendor. AMD dan Intel, serta vendor chip lengan menerapkan mikro dan calxeda, telah berjanji untuk mendukung papan ini dengan produk SOC (System on Chip) baru.

Itu adalah salah satu dari beberapa item berita yang keluar dari KTT Komputasi Terbuka bulan lalu di Santa Clara, CA. Secara total, pengumuman menunjuk ke masa depan di mana pelanggan dapat “meningkatkan melalui beberapa generasi prosesor tanpa harus mengganti motherboard atau jaringan in-rack,” kata Frankovsky dalam posting blog.

Calxeda muncul dengan papan server berbasis ARM yang dapat meluncur ke sistem penyimpanan lemari besi terbuka Facebook, dengan nama kode “Knox.”” Mengubah perangkat penyimpanan menjadi server penyimpanan dan menghilangkan kebutuhan server terpisah untuk mengontrol hard drive, “kata Frankovsky. (Facebook tidak menggunakan server lengan hari ini karena membutuhkan dukungan 64-bit, tetapi Frankovsky mengatakan “segalanya menjadi menarik” dalam teknologi lengan.)

Intel juga berkontribusi desain untuk teknologi fotonik silikon yang akan datang yang akan memungkinkan interkoneksi 100Gbps, 10 kali lebih cepat daripada koneksi Ethernet yang digunakan Facebook di pusat datanya saat ini. Dengan latensi rendah yang diaktifkan oleh kecepatan semacam itu, pelanggan mungkin dapat memisahkan CPU, DRAM, dan penyimpanan menjadi bagian -bagian rak yang berbeda dan hanya menambah atau mengurangi komponen alih -alih seluruh server saat dibutuhkan, kata Frankovsky. Dalam skenario ini, beberapa host dapat berbagi sistem flash, meningkatkan efisiensi.

Terlepas dari semua desain khusus ini yang berasal dari luar dunia OEM, HP dan Dell tidak sepenuhnya tertinggal. Mereka telah beradaptasi untuk mencoba menangkap beberapa pelanggan yang menginginkan fleksibilitas desain komputasi terbuka. Seorang Eksekutif Dell mengirimkan salah satu keynote di KTT Komputasi Terbuka tahun ini, dan baik HP dan Dell tahun lalu mengumumkan “Server Sheet Bersih dan Desain Penyimpanan” yang kompatibel dengan spesifikasi “rak terbuka” proyek komputasi terbuka.

Selain menjadi baik untuk Facebook, Frankovsky berharap komputasi terbuka akan menguntungkan pelanggan server secara umum. Fidelity dan Goldman Sachs adalah di antara mereka yang menggunakan desain khusus yang disetel ke beban kerja mereka sebagai hasil dari komputasi terbuka. Pelanggan yang lebih kecil mungkin dapat mendapat manfaat juga, bahkan jika mereka menyewa ruang dari pusat data di mana mereka tidak dapat mengubah server atau desain rak, katanya. Mereka dapat “mengambil blok bangunan [dari komputasi terbuka] dan merestrukturisasi mereka menjadi desain fisik yang sesuai dengan slot server mereka,” kata Frankovsky.

“Industri ini bergeser dan berubah dengan cara yang baik, mendukung konsumen, karena komputasi terbuka,” katanya.