Το Facebook έχει τα δικά του datacenters

Το Facebook έχει τα δικά του κέντρα δεδομένων?

Περίληψη:

Το Meta (πρώην Facebook) διαθέτει επί του παρόντος 47 κέντρα δεδομένων υπό κατασκευή, με σχέδια να έχουν περισσότερα από 70 κτίρια στο εγγύς μέλλον. Αυτό αντικατοπτρίζει την παγκόσμια επέκταση της υποδομής της εταιρείας, με 18 πανεπιστημιουπόλεις του κέντρου δεδομένων παγκοσμίως να συνολικά 40 εκατομμύρια τετραγωνικά πόδια. Παρά τις προκλήσεις που θέτουν οι διαταραχές της πανδημίας και της εφοδιαστικής αλυσίδας, η Meta αναμένει να επενδύσει μεταξύ 29 δισεκατομμυρίων δολαρίων και 34 δισεκατομμυρίων δολαρίων σε κεφαλαιουχικές δαπάνες το 2022.

Βασικά σημεία:

- Το Meta διαθέτει 47 κέντρα δεδομένων υπό κατασκευή και σχέδια για περισσότερα από 70 κτίρια στο εγγύς μέλλον.

- Η εταιρεία διαθέτει 18 πανεπιστημιουπόλεις του κέντρου δεδομένων παγκοσμίως.

- Η επέκταση κατά τη διάρκεια των διαταραχών της πανδημίας και της αλυσίδας εφοδιασμού είναι προκλητική.

- Η Meta αναμένει να επενδύσει μεταξύ 29 δισεκατομμυρίων δολαρίων και 34 δισεκατομμυρίων δολαρίων σε κεφαλαιουχικές δαπάνες το 2022.

- Οι χειριστές υπερέκρουσας, όπως η Meta και η Microsoft.

- Το Open Compute Project, που ιδρύθηκε από το Facebook, οδηγεί την καινοτομία στο υλικό.

- Η κατασκευή του κέντρου δεδομένων απαιτεί ευέλικτες διαδικασίες επιλογής και κατασκευής χώρου.

- Η Meta κοιτάζει τους πωλητές και τους εργολάβους ως συνεργάτες στην οδήγηση βέλτιστων πρακτικών και συνεχούς βελτίωσης.

- Οι Meta και άλλοι χειριστές υπερέκρουσας πρωτοπορούν νέες στρατηγικές για την παροχή κλίμακας και ταχύτητας.

- Η κλίμακα και η πρόκληση του προγράμματος Data Center είναι μια κινητήρια δύναμη για το meta.

Ερωτήσεις:

- Ποια είναι η τρέχουσα κατάσταση της κατασκευής του κέντρου δεδομένων της Meta?

- Πόσες πανεπιστημιουπόλεις του Κέντρου Δεδομένων έχουν το Meta παγκοσμίως?

- Τι προκλήσεις αντιμετωπίζει το Meta στην επέκταση του κέντρου δεδομένων?

- Πόσο σχεδιάζει η μετα -σχεδιάζει να επενδύσει σε κεφαλαιουχικές δαπάνες το 2022?

- Ποιες εταιρείες επενδύουν επίσης στην επέκταση της υποδομής του Κέντρου Δεδομένων?

- Ποιος είναι ο ρόλος του έργου Open Compute?

- Ποιοι παράγοντες είναι σημαντικοί στην κατασκευή του κέντρου δεδομένων?

- Πώς προβάλλετε τους πωλητές και τους εργολάβους Meta?

- Ποιες στρατηγικές είναι πρωτοποριακοί φορείς υπερέκλεξης?

- Τι οδηγεί το πρόγραμμα Data Center της Meta?

Το Meta διαθέτει σήμερα 47 κέντρα δεδομένων, με σχέδια για περισσότερα από 70 κτίρια στο εγγύς μέλλον.

Το Meta διαθέτει 18 πανεπιστημιουπόλεις του Κέντρου Δεδομένων παγκοσμίως.

Η επέκταση του κέντρου δεδομένων κατά τη διάρκεια των διαταραχών της πανδημίας και της εφοδιαστικής αλυσίδας δημιουργεί προκλήσεις για το meta.

Η Meta αναμένει να επενδύσει μεταξύ 29 δισεκατομμυρίων δολαρίων και 34 δισεκατομμυρίων δολαρίων σε κεφαλαιουχικές δαπάνες το 2022.

Οι χειριστές υπερέκρουσας όπως η Microsoft επενδύουν επίσης δισεκατομμύρια για την επέκταση της υποδομής του κέντρου δεδομένων τους.

Το Open Compute Project, που ιδρύθηκε από το Facebook, οδηγεί την καινοτομία στο υλικό.

Η κατασκευή του κέντρου δεδομένων απαιτεί ευέλικτες διαδικασίες επιλογής και κατασκευής χώρου.

Η Meta βλέπει τους πωλητές και τους εργολάβους ως εταίρους στην οδήγηση βέλτιστων πρακτικών και συνεχούς βελτίωσης.

Οι Meta και άλλοι χειριστές υπερέκρουσας πρωτοπορούν νέες στρατηγικές για την παροχή κλίμακας και ταχύτητας.

Η κλίμακα και η πρόκληση του προγράμματος Data Center είναι μια κινητήρια δύναμη για το meta.

Το Facebook έχει τα δικά του datacenters

Τι άλλο απογυμνώνει το Facebook? Ο Φράνκοφσκι είπε ότι “πολλές μητρικές πλακέτες σήμερα έρχονται με πολλή διαχείριση goop. Αυτός είναι ο τεχνικός όρος που μου αρέσει να χρησιμοποιώ για αυτό.”Αυτό το GOOP θα μπορούσε να είναι ο ενσωματωμένος μηχανισμός διαχείρισης του κύκλου ζωής της HP ή τα εργαλεία διαχείρισης απομακρυσμένων διακομιστών της Dell.

Το Facebook διαθέτει 47 κέντρα δεδομένων υπό κατασκευή

Η Meta έχει σήμερα 47 κέντρα δεδομένων υπό κατασκευή, δήλωσε η εταιρεία αυτή την εβδομάδα, αντανακλώντας το έκτακτο πεδίο της συνεχιζόμενης επέκτασης του κόσμου’ψηφιακή υποδομή.

Το’είναι μια σύντομη δήλωση, βαθιά μέσα σε μια μακρά ανασκόπηση της καινοτομίας στο Facebook’ψηφιακή υποδομή. Αλλά για όποιον γνωρίζει τη βιομηχανία κέντρων δεδομένων, αυτό’είναι ένα πραγματικό μάτι ανοιχτό.

“Όπως εγώ’Γράφοντας αυτό, έχουμε 48 ενεργά κτίρια και άλλα 47 κτίρια υπό κατασκευή,” Ο εν λόγω Tom Furlong, Πρόεδρος της Υποδομής, Κέντρα Δεδομένων στο Meta (πρώην Facebook). “Εμείς’θα έχετε περισσότερα από 70 κτίρια στο εγγύς μέλλον.”

Η δήλωση αντικατοπτρίζει το εξαιρετικό πεδίο του meta’η παγκόσμια επέκταση της υποδομής. Η εταιρεία διαθέτει 18 πανεπιστημιουπόλεις του Κέντρου Δεδομένων σε όλο τον κόσμο, οι οποίες μετά την ολοκλήρωση θα εκτείνονται 40 εκατομμύρια τετραγωνικά πόδια του χώρου του κέντρου δεδομένων.

Η κατοχή 47 κτιρίων υπό κατασκευή θα ήταν μια πρόκληση σε οποιεσδήποτε συνθήκες, αλλά ιδιαίτερα κατά τη διάρκεια μιας παγκόσμιας διαταραχής της πανδημίας και της εφοδιαστικής αλυσίδας. Το’Δεν είναι εύκολο ή φθηνό. Η Meta αναφέρει ότι αναμένει να επενδύσει μεταξύ 29 δισεκατομμυρίων δολαρίων και 34 δισεκατομμυρίων δολαρίων σε κεφαλαιουχικές δαπάνες το 2022, από 19 δισεκατομμύρια δολάρια πέρυσι.

Το’Δεν είναι μόνοι, καθώς οι μεγαλύτεροι φορείς υπερέκρουσας ρίχνουν δισεκατομμύρια δολάρια στην επέκταση της υποδομής του κέντρου δεδομένων τους για να καλύψουν τη ζήτηση για τις ψηφιακές υπηρεσίες τους. Οι κεφαλαιουχικές δαπάνες υπερέκφρασης αυξήθηκαν κατά 30 % το πρώτο εξάμηνο του 2021, σύμφωνα με ανάλυση της ερευνητικής ομάδας Synergy, η οποία παρακολουθεί 19 παρόχους υπερέκκυρης που δαπάνησαν περίπου 83 δισεκατομμύρια δολάρια στην περίοδο των έξι μηνών.

Αυτά τα επίπεδα δαπανών θα μπορούσαν εύκολα να αυξηθούν, υπό το πρίσμα του Facebook’Προβλέψεις για τις μελλοντικές δαπάνες Capex και τη Microsoft’Σχέδια για την κατασκευή 50 έως 100 κέντρων δεδομένων το χρόνο.

Καινοτομία υποδομής σε επική κλίμακα

Φόν του μίλιου’s blog post about meta’Το ταξίδι του Κέντρου Δεδομένων S είναι χρήσιμη ανάγνωση, όπως και μια σύντομη θέση που κοιτάζει πίσω στην πρόοδο του Open Compute Project, The Open Hardware Initiative που ιδρύθηκε από το Facebook το 2011.

“Το Open Hardware οδηγεί στην καινοτομία και η συνεργασία με περισσότερους προμηθευτές σημαίνει περισσότερες ευκαιρίες για ανάπτυξη υλικού επόμενης γενιάς για την υποστήριξη των σημερινών και αναδυόμενων χαρακτηριστικών σε όλη την Meta’οικογένεια τεχνολογιών.,” Ο Furlong γράφει.

Η ανάγκη καινοτομίας σε κλίμακα έχει επίσης συμπεριλάβει την κατασκευή του κέντρου δεδομένων.

“Υπάρχει μεγάλη δραστηριότητα στο κέντρο δεδομένων και τις κατασκευαστικές βιομηχανίες σήμερα, γεγονός που μας ασκεί πίεση για να βρούμε τους σωστούς ιστότοπους και συνεργάτες,” εν λόγω φουλάνγκ. “Σημαίνει επίσης ότι πρέπει να δημιουργήσουμε πιο ευέλικτες διαδικασίες επιλογής και κατασκευής τοποθεσίας. Όλη αυτή η προσπάθεια περιλαμβάνει επίσης την εξέταση των πωλητών και των εργολάβων μας περισσότερο ως συνεργάτες σε όλα αυτά. Μπορούμε’να το κάνω μόνο για δολάρια. Πρέπει να το κάνουμε για την απόδοση. Πρέπει να το κάνουμε για την οδήγηση βέλτιστων πρακτικών και συνεχούς βελτίωσης.

“Μα αυτό’Δεν είναι ο τρόπος με τον οποίο λειτουργεί συνήθως η κατασκευαστική βιομηχανία,” συνέχισε. “Λοιπόν, εμείς’Το VE έπρεπε να φέρει πολλές από τις δικές μας ιδέες σχετικά με τις λειτουργίες που λειτουργούν και να βελτιώσουν και να τους εντυπωσιάσουμε στις εταιρείες με τις οποίες συνεργαζόμαστε.”

Η ψηφιακή υποδομή γίνεται όλο και πιο σημαντική κάθε μέρα, και η Meta και οι ομόλογοι υπερέκρουσας είναι πρωτοπόροι νέες στρατηγικές για την παροχή της κλίμακας και της ταχύτητας που χρειάζονται. Το’είναι μια συνεχιζόμενη διαδικασία, όπως αντανακλά ο Furlong.

“Η μετακίνηση στο Κέντρο Δεδομένων δεν θα ήταν ποτέ εύκολη,” αυτός γράφει. “Αλλά νομίζω ότι εμείς’κατέληξε με ένα εκπληκτικό πρόγραμμα σε μια κλίμακα που ποτέ δεν θα φανταζόμουν ποτέ. Και εμείς’Πάντα ζητείται να κάνει περισσότερα. Οτι’είναι η επιχειρηματική πρόκληση και αυτό’είναι πιθανώς ένα από τα κύρια πράγματα που με κρατούν και η ομάδα μου έρχεται στη δουλειά κάθε μέρα. Έχουμε αυτή την τεράστια πρόκληση μπροστά μας να κάνουμε κάτι που είναι απίστευτα μαζικό σε κλίμακα.”

Το Facebook έχει τα δικά του datacenters

Επιστροφή στο σπίτι στο blog

20 20 2016

Infrastructure Facebook: Στρατηγική και ανάπτυξη στο κέντρο δεδομένων

Από μετα -σταδιοδρομία

Η Rachel Peterson οδηγεί την Ομάδα Στρατηγικής Data Center Infrastructure Center του Facebook. Η ομάδα της διαχειρίζεται το χαρτοφυλάκιο του Κέντρου Δεδομένων του Facebook και παρέχει στρατηγική υποστήριξη για τον εντοπισμό ευκαιριών για περαιτέρω βιωσιμότητα, αποτελεσματικότητα και αξιοπιστία υποδομής. Ρίξτε μια ματιά στην εμπειρία της στο Facebook και πώς η ομάδα της εργάζεται για τη σύνδεση του κόσμου.

Ποια είναι η ιστορία σας στο Facebook?

Μπήκα στο Facebook το 2009, όταν η εταιρεία ήταν έτοιμη να ξεκινήσει το πρώτο της κέντρο δεδομένων στο Prineville, Oregon. Εκείνη την εποχή, ολόκληρη η ομάδα του κέντρου δεδομένων αποτελείται από λιγότερα από 30 μέλη της ομάδας και το Facebook κατείχε δύο μικρά αποτυπώματα συν-τοποθεσίας στις ΗΠΑ. Μπήκα για να βοηθήσω στην οικοδόμηση του προγράμματος επιλογής ιστότοπου για τα κέντρα δεδομένων του Facebook. Σήμερα, η ομάδα μας περιλαμβάνει πάνω από 100 άτομα σε πολλές τοποθεσίες σε όλο τον κόσμο.

Γρήγορα προς τα εμπρός μέχρι σήμερα, το Facebook κατέχει τώρα και λειτουργεί ένα μεγάλο χαρτοφυλάκιο κέντρων δεδομένων, που καλύπτουν τις ΗΠΑ, την Ευρώπη και την Ασία. Το πρόγραμμα επιλογής τοποθεσίας ξεκίνησε με επιτυχία δεκαπέντε τεράστια κέντρα δεδομένων και είμαστε αφοσιωμένοι στην τροφοδοσία αυτών των κέντρων δεδομένων με 100% ανανεώσιμες πηγές ενέργειας. Το 2012, θέσαμε τον πρώτο στόχο μας με 25% καθαρή και ανανεώσιμη ενέργεια στο μίγμα τροφοδοσίας ηλεκτρικής ενέργειας το 2015 για όλα τα κέντρα δεδομένων. Το 2017, ξεπεράσαμε το 50% καθαρή και ανανεώσιμη ενέργεια για όλες τις λειτουργίες του Facebook. Το 2018, θέσαμε τον επόμενο επιθετικό στόχο μας – με στόχο να συναντήσουμε 100% καθαρή και ανανεώσιμη ενέργεια για όλες τις αναπτυσσόμενες επιχειρήσεις του Facebook μέχρι το τέλος του 2020.

Ήταν πραγματικά συναρπαστικό να είμαστε στην πρώτη γραμμή αυτής της ανάπτυξης και να οικοδομήσουμε την ομάδα που έχει διαδραματίσει κρίσιμο ρόλο στην ανάπτυξη της υποδομής του Facebook. Δεν υπήρξε ποτέ μια θαμπή στιγμή σε αυτό το εκπληκτικό ταξίδι! Η ανάπτυξη του Facebook έχει καταστήσει τόσο δύσκολο όσο και διασκεδαστικό και δεν νομίζω ότι μια μέρα έχει περάσει από πού δεν έμαθα. Λατρεύω αυτό που κάνω και είμαι πραγματικά τυχερός που συνεργάζομαι με μια τέτοια εκπληκτική ομάδα διασκέδασης. Η κουλτούρα του Facebook εξουσιοδοτεί την ομάδα μου να έχει μεγάλες επιπτώσεις και μαζί κάνουμε τον κόσμο πιο ανοιχτό και συνδεδεμένο. ένα κέντρο δεδομένων κάθε φορά.

Η αποστολή του Facebook είναι να κάνει τον κόσμο πιο ανοιχτό και συνδεδεμένο, ποιος έχει ο ρόλος που έχει η ομάδα σας σε αυτό?

Οδηγεί τη στρατηγική της παγκόσμιας τοποθεσίας του Facebook και τις προσπάθειες επιλογής τοποθεσιών βάσει ορισμένων κριτηρίων κρίσιμης τοποθέτησης, συμπεριλαμβανομένων νέων ανανεώσιμων πηγών ενέργειας για την υποστήριξη των ιστότοπων.

Διαχειρίζεται προγράμματα παγκόσμιας περιβαλλοντικής συμμόρφωσης του Facebook, από την επιλογή ιστότοπων σε όλες τις λειτουργίες, συμπεριλαμβανομένης της συμμόρφωσης με αέρα και νερό.

Οδηγεί τα παγκόσμια ενεργειακά προγράμματα του Facebook, από την επιλογή του χώρου σε όλες τις λειτουργίες, τη βελτιστοποίηση της ενεργειακής προσφοράς για 100% ανανεώσιμες πηγές ενέργειας, ενώ εξασφαλίζει τη δημοσιονομική ευθύνη και την αξιοπιστία.

Οδηγεί τον στρατηγικό σχεδιασμό, την ενεργοποίηση και την παρακολούθηση του οδικού χάρτη παγκόσμιου κέντρου δεδομένων.

Παρέχει υποστήριξη επιστήμης δεδομένων για να επιτρέψει τις στρατηγικές αποφάσεις και τη βελτιστοποίηση των επιδόσεων σε ολόκληρο τον κύκλο ζωής του κέντρου δεδομένων.

Οδηγεί το έργο δέσμευσης της κοινότητας σε τοποθεσίες όπου έχουμε κέντρα δεδομένων.

Αναπτύσσει και διαχειρίζεται τις στρατηγικές πολιτικής και κινδύνου για να επιτρέψει την παγκόσμια επέκταση του Facebook’αποτύπωμα υποδομής.

Το Facebook δεσμεύεται να είναι μια δύναμη για το καλό όπου εργαζόμαστε παρέχοντας θέσεις εργασίας, αυξάνοντας την οικονομία και υποστηρίζοντας προγράμματα που ωφελούν τις κοινότητες στις οποίες ζούμε.

Η ομάδα βιωσιμότητας’Η αποστολή είναι να υποστηρίξει το Facebook’η ικανότητα να λειτουργεί και να αναπτύσσεται αποτελεσματικά και υπεύθυνα και να ενδυναμώσει τους ανθρώπους να κατασκευάζουν βιώσιμες κοινότητες.

Οδηγεί τη στρατηγική σε ολόκληρη την εταιρεία στην οδήγηση της επιχειρησιακής αριστείας από το σχεδιασμό, την κατασκευή και τη λειτουργία της επιχείρησής μας. Δίνουμε προτεραιότητα στην αποτελεσματικότητα, τη διατήρηση του νερού και την αριστεία της εφοδιαστικής αλυσίδας και είμαστε περήφανοι που λέμε ότι οι εγκαταστάσεις μας είναι από τις πιο νερού και ενεργειακά αποδοτικά στον κόσμο.

Είμαστε αφοσιωμένοι στην καταπολέμηση της κλιματικής αλλαγής και έχουμε θέσει έναν στόχο που βασίζεται στην επιστήμη για να μειώσουμε τις εκπομπές μας κατά 75 % μέχρι το 2020.

Οι βασικές τιμές του Facebook κινούνται γρήγορα, εστιάζουν στην πρόσκρουση, οικοδομούν κοινωνική αξία, να είναι ανοιχτά, να είναι τολμηροί. Ποια αξία αντηχεί πραγματικά με την ομάδα σας?

Επικεντρωθείτε στον αντίκτυπο. Η ομάδα μας είναι σχετικά άπαχη και όμως έχουμε την ικανότητα να προσφέρουμε πολλές πρωτοβουλίες υψηλού επιπτώσεων για την εταιρεία.

Τι είναι κάτι που οι περισσότεροι άνθρωποι δεν γνωρίζουν για την ομάδα σας?

Έχουμε μια πολύ διαφορετική ομάδα που αποτελείται από δικηγόρους, διαχειριστές δημόσιας πολιτικής, οικονομικούς αναλυτές, διαχειριστές προγραμμάτων, επιστήμονες δεδομένων, επαγγελματίες ενέργειας, μηχανικούς και εμπειρογνώμονες επιχειρηματικών διαδικασιών.

Μπορείτε να μοιραστείτε για να είστε γυναίκες ηγέτης στον κλάδο της τεχνολογίας και η σημασία της ποικιλομορφίας στο Facebook και την τεχνολογία γενικά?

Ένας από τους λόγους για τους οποίους μου αρέσει να εργάζομαι στο Facebook είναι η δέσμευσή μας για ποικιλομορφία. Η ποικιλομορφία δεν είναι εξωσχολική δραστηριότητα στο Facebook, αλλά κάτι που στοχεύουμε να εφαρμόσουμε σε όλα τα επίπεδα της εταιρείας. Παρόλο που εμείς και η βιομηχανία τεχνολογίας στο σύνολό της έχουμε περισσότερη δουλειά εδώ, ενισχύουμε συνεχώς αυτή τη δέσμευση μέσω του πολιτισμού μας, των προϊόντων μας και των προτεραιοτήτων μας.

Ως γυναίκα στην τεχνολογία, γνωρίζω από πρώτο χέρι πόσο σημαντική είναι η ποικιλομορφία στη βιομηχανία μας και πόσο διαφορετικές προοπτικές οδηγούν καλύτερα αποτελέσματα. Είναι πολύ σημαντικό να κάνουμε ό, τι μπορούμε για να βελτιώσουμε την πρόσληψη διαφόρων υποψηφίων και να ενθαρρύνουμε τις γυναίκες να συμμετέχουν σε τομείς που συνήθως κυριαρχούνται. Βρήκα την καριέρα μου να καλεί στην επιλογή των ακινήτων, μια βιομηχανία που κυριαρχείται παραδοσιακά άνδρες, και βρήκα την έμπνευσή μου μέσα από τις πολλές ταλαντούχες γυναίκες που με ενέπνευσαν και με καθοδηγούσαν στην πορεία. Σήμερα, ως ηγέτης της γυναίκας στην τεχνολογία, είναι το καθήκον και το προνόμιά μου να είμαι μέντορας στις γυναίκες και να κάνω ό, τι μπορώ για να υποστηρίξω ενεργά την ανάπτυξη και την πρόοδο των γυναικών σε αυτόν τον κλάδο.

Η συμβουλή μου για τις γυναίκες? Βρείτε τα πάθη σας και ακολουθήστε τα, ακόμα κι αν καταλήξετε να βρίσκεστε σε μια περιοχή όπου εσείς’κανονικά η μόνη γυναίκα στο δωμάτιο. Τα δυνατά σας θα αναπτυχθούν μέσω των πάθη σας και εσείς’Θα δουλέψω σκληρότερα στο σκάφος σας. Η καριέρα σας θα βρει τη δική της τροχιά. Το πιο σημαντικό, αφήστε τον εαυτό σας να αποτύχει κάποιο δωμάτιο και να επιστρέψετε δεξιά αν σκοντάψετε κατά μήκος του δρόμου.

Το Facebook έχει τα δικά του datacenters

Facebook’Οι υπηρεσίες S βασίζονται σε στόλους διακομιστών σε κέντρα δεδομένων σε όλο τον κόσμο – όλες τις εφαρμογές που εκτελούνται και παρέχοντας την απόδοση των υπηρεσιών που χρειάζονται οι υπηρεσίες μας. Αυτός είναι ο λόγος για τον οποίο πρέπει να διασφαλίσουμε ότι το υλικό του διακομιστή είναι αξιόπιστο και ότι μπορούμε να διαχειριστούμε τις αποτυχίες υλικού διακομιστή στην κλίμακα μας με όσο το δυνατόν μικρότερη διαταραχή στις υπηρεσίες μας.

Τα ίδια τα εξαρτήματα υλικού μπορούν να αποτύχουν για οποιονδήποτε αριθμό λόγων, συμπεριλαμβανομένης της υποβάθμισης υλικού (e.σολ., τα μηχανικά εξαρτήματα μιας μονάδας δίσκου περιστροφής), μια συσκευή που χρησιμοποιείται πέρα από το επίπεδο αντοχής της (ες.σολ., Συσκευές NAND Flash), περιβαλλοντικές επιπτώσεις (e.σολ., διάβρωση λόγω υγρασίας) και ελαττώματα παραγωγής.

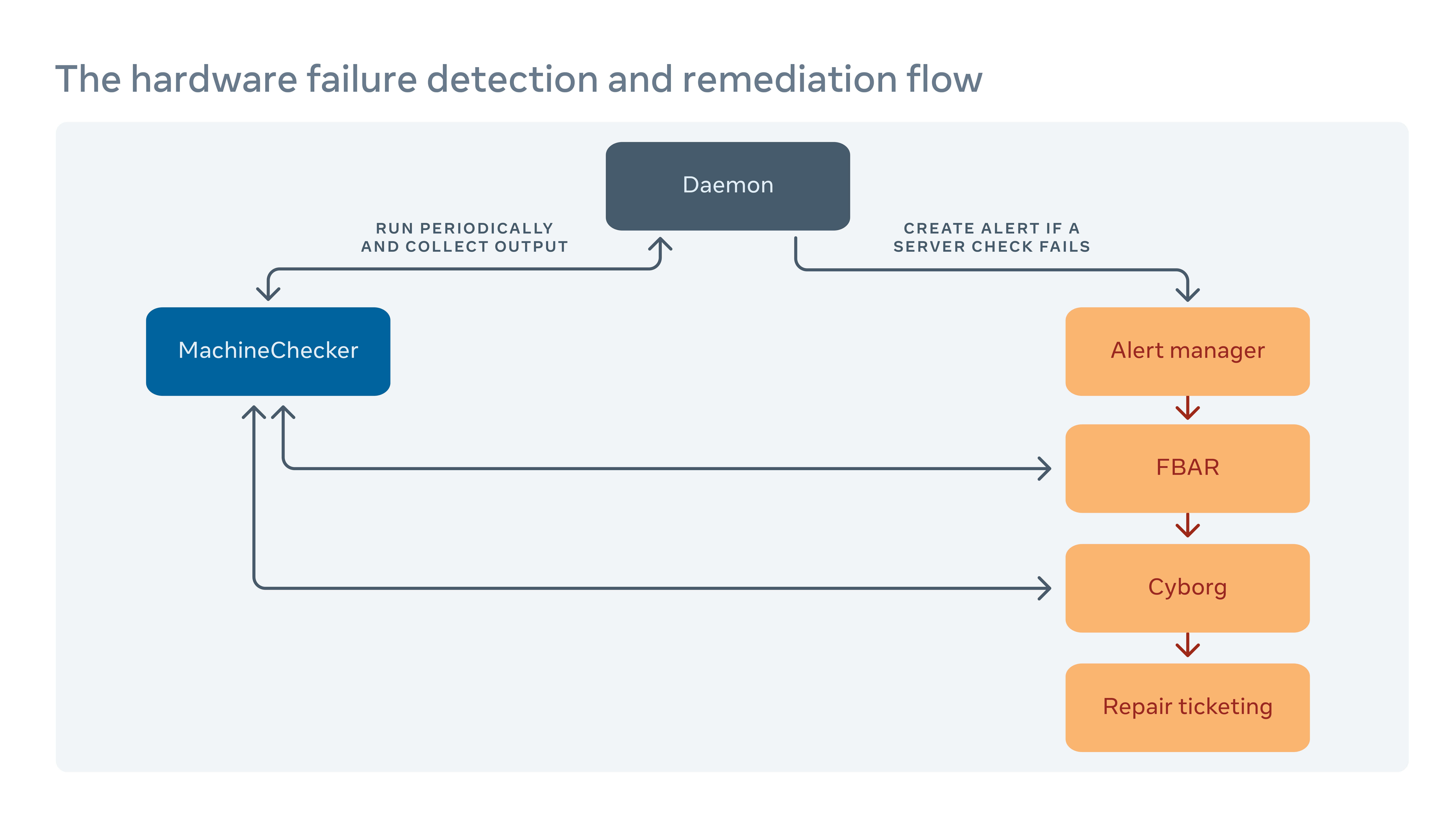

Γενικά, αναμένουμε πάντα κάποιο βαθμό αποτυχίας υλικού στα κέντρα δεδομένων μας, γι ‘αυτό εφαρμόζουμε συστήματα όπως το σύστημα διαχείρισης συμπλέγματος για την ελαχιστοποίηση των διακοπών υπηρεσιών. Σε αυτό το άρθρο εμείς’Εισαγωγή τεσσάρων σημαντικών μεθοδολογιών που μας βοηθούν να διατηρήσουμε υψηλό βαθμό διαθεσιμότητας υλικού. Έχουμε κατασκευάσει συστήματα που μπορούν να ανιχνεύσουν και να αποκαταστήσουν προβλήματα . Παρακολουθούμε και αποκαθιστούμε τα συμβάντα υλικού χωρίς να επηρεάζουν δυσμενώς την απόδοση των εφαρμογών . Υιοθετούμε προληπτικές προσεγγίσεις για επισκευές υλικού και χρησιμοποιούμε μεθοδολογία πρόβλεψης για αποκατάστασης . Και αυτοματοποιούμε την ανάλυση των βασικών αιτίων για αποτυχίες υλικού και συστήματος σε κλίμακα για να φτάσουμε γρήγορα στο κάτω μέρος των προβλημάτων.

Πώς χειρίζουμε την αποκατάσταση υλικού

Διεξάγουμε περιοδικά ένα εργαλείο που ονομάζεται MachineChecker σε κάθε διακομιστή για την ανίχνευση αποτυχιών υλικού και συνδεσιμότητας. Μόλις η MachineChecker δημιουργήσει μια ειδοποίηση σε ένα κεντρικό σύστημα χειρισμού ειδοποίησης, ένα εργαλείο που ονομάζεται Facebook Auto-Remediation (FBAR) στη συνέχεια παίρνει την ειδοποίηση και εκτελεί προσαρμόσιμες αποκατάστασης για να διορθώσει το σφάλμα. Για να βεβαιωθείτε ότι εκεί’είναι ακόμα αρκετή χωρητικότητα για το Facebook’Υπηρεσίες S, μπορούμε επίσης να ορίσουμε όρια επιτοκίων για να περιορίσουμε τον αριθμό των διακομιστών να επισκευαστούν ανά πάσα στιγμή.

Εάν το FBAR μπορεί’T Φέρτε έναν διακομιστή πίσω σε μια υγιή κατάσταση, η αποτυχία μεταβιβάζεται σε ένα εργαλείο που ονομάζεται Cyborg. Το Cyborg μπορεί να εκτελέσει αποκαταστάσεις χαμηλότερου επιπέδου, όπως αναβαθμίσεις υλικολογισμικού ή πυρήνα, και επανεμφάνιση. Εάν το ζήτημα απαιτεί χειρωνακτική επισκευή από τεχνικό, το σύστημα δημιουργεί ένα εισιτήριο στο σύστημα επισκευής επισκευών μας.

Βυθίζουμε βαθύτερα σε αυτήν τη διαδικασία στο χαρτί μας “Αποκατάσταση υλικού σε κλίμακα.”

Πώς ελαχιστοποιούμε τον αρνητικό αντίκτυπο της αναφοράς σφαλμάτων στην απόδοση του διακομιστή

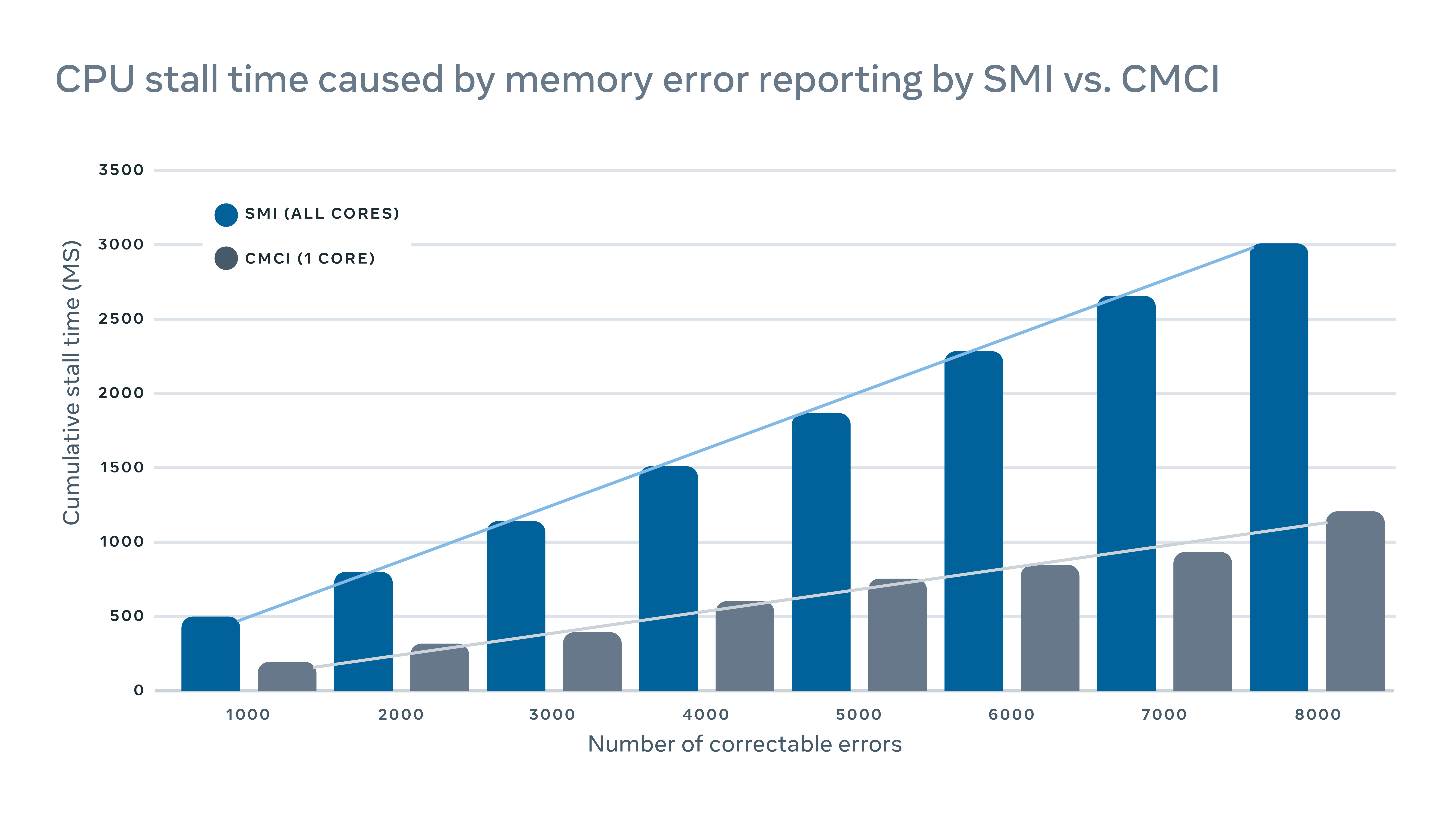

Το MachineChecker ανιχνεύει αποτυχίες υλικού ελέγχοντας διάφορα αρχεία καταγραφής διακομιστή για τις αναφορές σφαλμάτων. Συνήθως, όταν εμφανιστεί ένα σφάλμα υλικού, θα ανιχνευθεί από το σύστημα (Ε (Ε.σολ., αποτυγχάνει στον έλεγχο της ισοτιμίας) και ένα σήμα διακοπής θα αποσταλεί στη CPU για χειρισμό και σύνδεση του σφάλματος.

Δεδομένου ότι αυτά τα σήματα διακοπής θεωρούνται σήματα υψηλής προτεραιότητας, η CPU θα σταματήσει την κανονική του λειτουργία και θα αφιερώσει την προσοχή της στο χειρισμό του σφάλματος. Αλλά αυτό έχει αρνητικό αντίκτυπο απόδοσης στον διακομιστή. Για την καταγραφή των διορθωτικών σφαλμάτων μνήμης, για παράδειγμα, μια παραδοσιακή διακοπή διαχείρισης συστήματος διακοπής (SMI) θα σταματούσε όλους τους πυρήνες CPU, ενώ η διακόπτη ελέγχου του διορθωτή μηχανή (CMCI) θα σταματούσε μόνο έναν από τους πυρήνες της CPU, αφήνοντας τους υπόλοιπους πυρήνες CPU που είναι διαθέσιμοι για κανονική λειτουργία.

Αν και οι πάγκοι της CPU διαρκούν συνήθως μόνο μερικές εκατοντάδες χιλιοστά του δευτερολέπτου, μπορούν ακόμα να διαταράξουν τις υπηρεσίες που είναι ευαίσθητες στην καθυστέρηση. Σε κλίμακα, αυτό σημαίνει ότι οι διακοπές σε μερικά μηχανήματα μπορούν να έχουν μια δυσμενείς επιπτώσεις στην απόδοση σε επίπεδο υπηρεσιών.

Για να ελαχιστοποιηθεί ο αντίκτυπος της απόδοσης που προκαλείται από την αναφορά σφαλμάτων, εφαρμόσαμε έναν υβριδικό μηχανισμό για την αναφορά σφάλματος μνήμης που χρησιμοποιεί τόσο CMCI όσο και SMI χωρίς να χάσει την ακρίβεια όσον αφορά τον αριθμό των διορθωτικών σφαλμάτων μνήμης.

Πώς αξιοποιούμε τη μηχανική μάθηση για να προβλέψουμε επισκευές

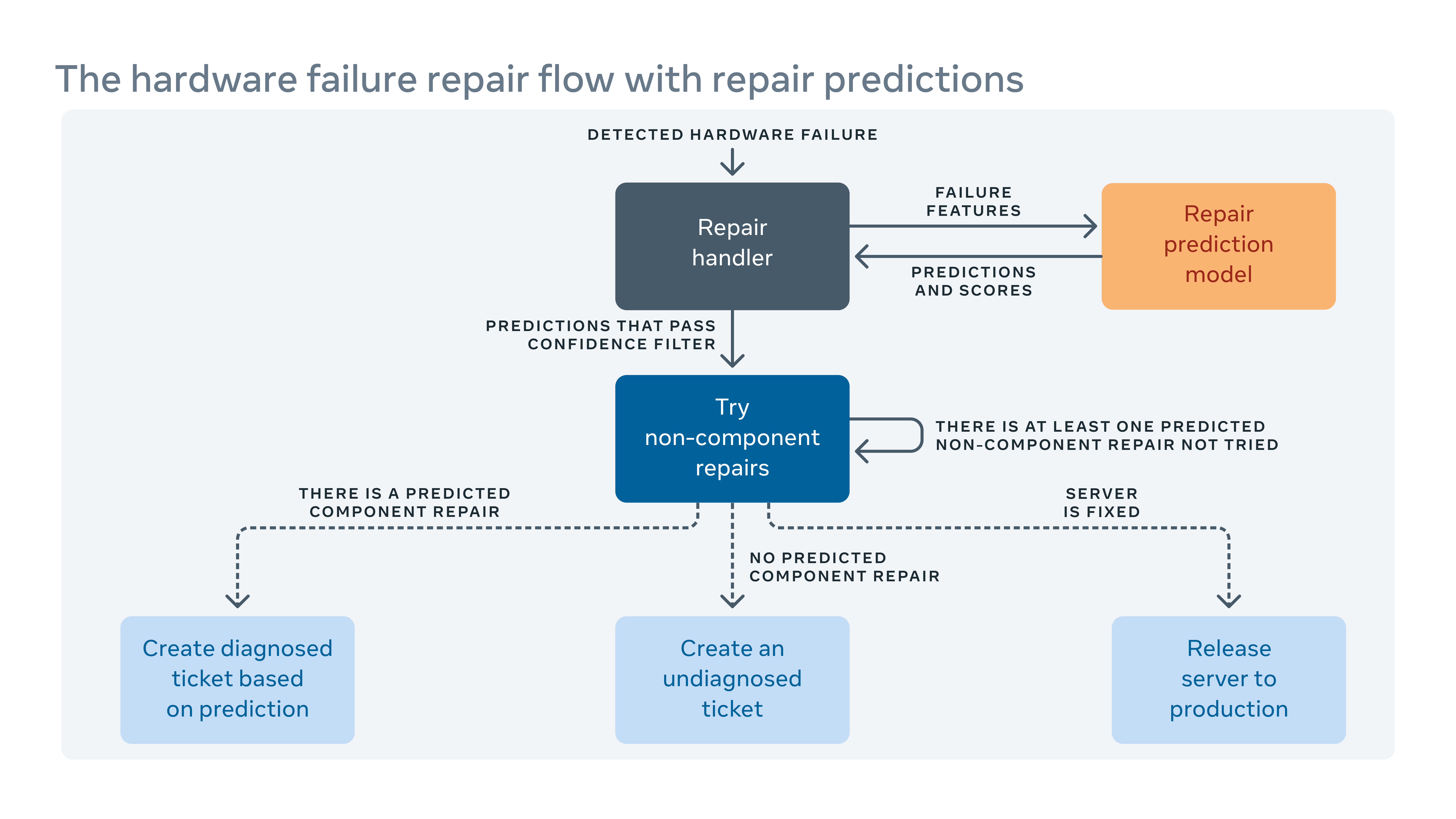

Δεδομένου ότι εισάγουμε συχνά νέες διαμορφώσεις υλικού και λογισμικού στα κέντρα δεδομένων μας, πρέπει επίσης να δημιουργήσουμε νέους κανόνες για το σύστημα αυτόματης παρακολούθησης.

Όταν το αυτοματοποιημένο σύστημα δεν μπορεί να διορθώσει μια αποτυχία υλικού, το ζήτημα αποδίδεται ένα εισιτήριο για χειροκίνητη επισκευή. Το νέο υλικό και το λογισμικό σημαίνουν νέους τύπους πιθανών αποτυχιών που πρέπει να αντιμετωπιστούν. Αλλά θα μπορούσε να υπάρξει ένα χάσμα μεταξύ του πότε εφαρμόζεται νέο υλικό ή λογισμικό και όταν είμαστε σε θέση να ενσωματώσουμε νέους κανόνες αποκατάστασης. Κατά τη διάρκεια αυτού του κενού, ορισμένα εισιτήρια επισκευής ενδέχεται να ταξινομηθούν ως “αδιάγνωστος,” Σημαίνει ότι το σύστημα έχει’πρότεινε μια δράση επισκευής ή “εσφαλμένος διαγνωσμένος,” Σημαίνει ότι η προτεινόμενη δράση επισκευής δεν είναι’αποτελεσματικός. Αυτό σημαίνει περισσότερο χρόνο εργασίας και συστήματος, ενώ οι τεχνικοί πρέπει να διαγνώσουν το θέμα οι ίδιοι.

Για να κλείσουμε το κενό, δημιουργήσαμε ένα πλαίσιο εκμάθησης μηχανών που μαθαίνει από το πώς οι αποτυχίες έχουν καθοριστεί στο παρελθόν και προσπαθεί να προβλέψουμε ποιες επισκευές θα ήταν απαραίτητες για τα τρέχοντα μη διαγνωσμένα και λανθασμένα εισιτήρια επισκευής. Με βάση το κόστος και επωφελείται από τις λανθασμένες και σωστές προβλέψεις, αναθέτουμε ένα κατώφλι για την εμπιστοσύνη πρόβλεψης για κάθε δράση επισκευής και βελτιστοποιούμε τη σειρά των ενεργειών επισκευής. Για παράδειγμα, σε ορισμένες περιπτώσεις θα προτιμούσαμε να δοκιμάσουμε πρώτα μια αναβάθμιση επανεκκίνησης ή υλικολογισμικού, επειδή αυτά τα είδη επισκευών Don’t απαιτεί οποιαδήποτε φυσική επισκευή υλικού και να πάρει λιγότερο χρόνο για να τελειώσει, οπότε ο αλγόριθμος πρέπει να συστήσει αυτό το είδος δράσης πρώτα. Απλώς, η μηχανική μάθηση μας επιτρέπει όχι μόνο να προβλέψουμε πώς να επιδιορθώσουμε ένα μη διαγνωσμένο ή λανθασμένο ζήτημα, αλλά και να δώσουμε προτεραιότητα στα πιο σημαντικά αυτά.

Πώς εμείς’ve αυτοματοποιημένη ανάλυση ρίζας στόλου

Εκτός από τα αρχεία καταγραφής διακομιστών που καταγράφουν επανεκκινήσεις, ο πυρήνας πανικοβάλλεται εκτός μνήμης κ.λπ., Υπάρχουν επίσης λογισμικά και αρχεία καταγραφής εργαλείων στο σύστημα παραγωγής μας. Αλλά η κλίμακα και η πολυπλοκότητα όλων αυτών των μέσων’είναι δύσκολο να εξετάσουμε όλα τα αρχεία καταγραφής από κοινού για να βρουν συσχετισμούς μεταξύ τους.

Εφαρμόσαμε ένα εργαλείο επεκτάσιμης ανάλυσης ρίζας-αιτίας (RCA) που ταξινομεί εκατομμύρια καταχωρήσεις καταγραφής (που περιγράφονται από ενδεχομένως εκατοντάδες στήλες) για να βρουν εύκολα κατανοητά και ενεργητικές συσχετίσεις.

Με την προ-συσσωμάτωση δεδομένων χρησιμοποιώντας SCUBA, μια βάση δεδομένων σε πραγματικό χρόνο σε μνήμη, βελτιώσαμε σημαντικά την επεκτασιμότητα ενός παραδοσιακού αλγόριθμου εξόρυξης μοτίβων, FP-Growth, για την εξεύρεση συσχετισμών σε αυτό το πλαίσιο RCA. Προσθέσαμε επίσης ένα σύνολο φίλτρων στις αναφερόμενες συσχετίσεις για τη βελτίωση της ερμηνείας του αποτελέσματος. Έχουμε αναπτύξει αυτόν τον αναλυτή ευρέως στο Facebook για το RCA για το ποσοστό αποτυχίας του εξαρτήματος υλικού, τις απροσδόκητες επανεκκινήσεις διακομιστή και τις αποτυχίες λογισμικού.

Ποιος χρειάζεται HP και Dell? Το Facebook σχεδιάζει τώρα όλους τους δικούς του διακομιστές

Το νεότερο κέντρο δεδομένων του Facebook δεν θα έχει διακομιστές OEM.

Jon Brodkin – 14 Φεβρουαρίου 2013 10:35 PM UTC

Σχόλια αναγνώστη

Σχεδόν πριν από δύο χρόνια, το Facebook παρουσίασε αυτό που ονομάζεται Open Compute Project. Η ιδέα ήταν να μοιραστούν σχέδια για το υλικό του κέντρου δεδομένων, όπως διακομιστές, αποθήκευση και ράφια.

Ενώ ο καθένας θα μπορούσε να επωφεληθεί, το Facebook οδήγησε το δρόμο για την ανάπτυξη του εξοπλισμένου υλικού στα δικά του κέντρα δεδομένων. Το έργο έχει πλέον προχωρήσει στο σημείο όπου όλοι οι νέοι διακομιστές που αναπτύσσονται από το Facebook έχουν σχεδιαστεί από το ίδιο το Facebook ή σχεδιάστηκαν από άλλους στις απαιτητικές προδιαγραφές του Facebook. Τα προσαρμοσμένα εργαλεία σήμερα καταλαμβάνουν περισσότερο από το ήμισυ του εξοπλισμού στα κέντρα δεδομένων Facebook. Στη συνέχεια, το Facebook θα ανοίξει ένα κέντρο δεδομένων 290.000 τετραγωνικών ποδιών στη Σουηδία που έχει αποθηκευτεί εξ ολοκλήρου με διακομιστές του δικού του σχεδίου, ένα πρώτο για την εταιρεία.

“Είναι το πρώτο όπου θα έχουμε 100 τοις εκατό ανοικτούς διακομιστές υπολογιστών μέσα”, δήλωσε ο Ars σε τηλεφωνική συνέντευξη του Frank Frankovsky, αντιπρόεδρος του σχεδιασμού υλικού και της αλυσίδας εφοδιασμού στο Facebook.

Όπως τα υπάρχοντα κέντρα δεδομένων του Facebook στη Βόρεια Καρολίνα και το Όρεγκον, αυτό που έρχεται σε απευθείας σύνδεση αυτό το καλοκαίρι στο Luleå, η Σουηδία θα έχει δεκάδες χιλιάδες διακομιστές. Το Facebook βάζει επίσης τα εργαλεία του σε μισθωμένο χώρο Data Center για να διατηρήσει παρουσία κοντά στους χρήστες σε όλο τον κόσμο, συμπεριλαμβανομένων 11 τοποθεσιών Colocation στις ΗΠΑ. Διάφοροι παράγοντες συμβάλλουν στην επιλογή των τοποθεσιών: φόρους, διαθέσιμη τεχνική εργασία, πηγή και κόστος εξουσίας και το κλίμα. Το Facebook δεν χρησιμοποιεί παραδοσιακό κλιματισμό, αντίθετα στηριζόμενη πλήρως στο “εξωτερικό αέρα και το μοναδικό σύστημα ψύξης εξατμίσεως για να διατηρήσει τους διακομιστές μας αρκετά δροσερό”, δήλωσε ο Frankovsky.

Εξοικονόμηση χρημάτων με την απογύμνωση του τι δεν κάνετε’ανάγκη

Στην κλίμακα του Facebook, είναι φθηνότερο να διατηρήσουμε τα δικά του κέντρα δεδομένων παρά να βασίζουμε σε παρόχους υπηρεσιών cloud, σημείωσε. Επιπλέον, είναι επίσης φθηνότερο για το Facebook να αποφεύγονται οι παραδοσιακοί πωλητές διακομιστών.

Όπως και η Google, το Facebook σχεδιάζει τους δικούς του διακομιστές και τους έχει κατασκευάσει από την ODMS (αρχικούς κατασκευαστές σχεδιασμού) στην Ταϊβάν και την Κίνα, αντί των ΚΑΕ (κατασκευαστές πρωτότυπου εξοπλισμού) όπως η HP ή η Dell. Με το Rolling του, το Facebook εξαλείφει αυτό που ο Frankovsky ονομάζει “δωρεάν διαφοροποίηση”, χαρακτηριστικά υλικού που κάνουν τους διακομιστές μοναδικούς αλλά δεν ωφελούν το Facebook.

Θα μπορούσε να είναι τόσο απλό όσο το πλαστικό στεφάνι σε ένα διακομιστή με λογότυπο μάρκας, επειδή αυτό το επιπλέον κομμάτι υλικού αναγκάζει τους οπαδούς να εργάζονται σκληρότερα. Ο Frankovsky δήλωσε ότι μια μελέτη έδειξε έναν τυπικό διακομιστή OEM μεγέθους 1U “που χρησιμοποιήθηκαν 28 watts της ισχύος ανεμιστήρα για να τραβήξει αέρα μέσω της σύνθετης αντίστασης που προκαλείται από αυτό το πλαστικό στεφάνη”, ενώ ο ισοδύναμος ανοικτός διακομιστής υπολογίζει μόλις τρία watts για το σκοπό αυτό.

Τι άλλο απογυμνώνει το Facebook? Ο Φράνκοφσκι είπε ότι “πολλές μητρικές πλακέτες σήμερα έρχονται με πολλή διαχείριση goop. Αυτός είναι ο τεχνικός όρος που μου αρέσει να χρησιμοποιώ για αυτό.”Αυτό το GOOP θα μπορούσε να είναι ο ενσωματωμένος μηχανισμός διαχείρισης του κύκλου ζωής της HP ή τα εργαλεία διαχείρισης απομακρυσμένων διακομιστών της Dell.

Αυτά τα χαρακτηριστικά θα μπορούσαν να είναι χρήσιμα για πολλούς πελάτες, ειδικά αν έχουν τυποποιηθεί σε έναν πωλητή. Αλλά στο μέγεθος του Facebook, δεν έχει νόημα να βασίζεστε μόνο σε έναν προμηθευτή, επειδή “ένα σφάλμα σχεδιασμού μπορεί να πάρει ένα μεγάλο μέρος του στόλου σας κάτω ή επειδή μια έλλειψη μέρους θα μπορούσε να εμποδίσει την ικανότητά σας να παραδώσετε προϊόν στα κέντρα δεδομένων σας.«

Το Facebook διαθέτει τα δικά του εργαλεία διαχείρισης δεδομένων, έτσι ώστε τα πράγματα που κάνει η HP ή η Dell Dell είναι περιττές. Ένα προϊόν προμηθευτή “έρχεται με το δικό του σύνολο διεπαφών χρήστη, σετ API και ένα όμορφο GUI για να σας πει πόσο γρήγορα οι οπαδοί περιστρέφονται και μερικά πράγματα που γενικά οι περισσότεροι πελάτες αναπτύσσουν αυτά τα πράγματα σε θέα στην κλίμακα ως δωρεάν διαφοροποίηση”, δήλωσε ο Frankovsky. “Είναι διαφορετικό με τρόπο που δεν έχει σημασία για μένα. Αυτό το επιπλέον όργανα στη μητρική πλακέτα, όχι μόνο κοστίζει χρήματα για να τα αγοράσει από την άποψη των υλικών, αλλά προκαλεί επίσης πολυπλοκότητα στις επιχειρήσεις.«

Μια διαδρομή για την HP και την Dell: Προσαρμόστε στο Open Compute

Αυτό δεν σημαίνει ότι το Facebook ορκίζεται από την HP και την Dell για πάντα. “Τα περισσότερα από τα νέα μας εργαλεία είναι χτισμένα από ODMs όπως η Quanta”, ανέφερε η εταιρεία σε απάντηση ηλεκτρονικού ταχυδρομείου σε μία από τις ερωτήσεις παρακολούθησης μας. “Κάνουμε όλα τα εργαλεία μας, και αν ένας ΚΑΕ μπορεί να χτίσει τα πρότυπά μας και να τα φέρει μέσα σε 5 τοις εκατό, τότε είναι συνήθως σε αυτές τις συζητήσεις πολλαπλών πηγών.«

Η HP και η Dell έχουν αρχίσει να δημιουργούν σχέδια που συμμορφώνονται για να ανοίξουν τις προδιαγραφές υπολογισμού και το Facebook δήλωσε ότι δοκιμάζει ένα από την HP για να δει αν μπορεί να κάνει την περικοπή. Ωστόσο, η εταιρεία επιβεβαίωσε ότι το νέο της κέντρο δεδομένων στη Σουηδία δεν θα περιλαμβάνει διακομιστές OEM όταν ανοίγει.

Το Facebook αναφέρει ότι παίρνει 24 % οικονομικές αποταμιεύσεις από την ύπαρξη υποδομής χαμηλότερου κόστους και εξοικονομεί 38 % στο συνεχιζόμενο λειτουργικό κόστος ως αποτέλεσμα της οικοδόμησης των δικών του υλικών. Οι διακομιστές που σχεδιάστηκαν από το Facebook δεν εκτελούν διαφορετικούς φόρτους εργασίας από οποιονδήποτε άλλο διακομιστή-απλώς τους τρέχουν πιο αποτελεσματικά.

“Ένας διακομιστής HP ή Dell, ή να ανοίξει το Compute Server, όλοι μπορούν γενικά να εκτελούν το ίδιο φόρτο εργασίας”, δήλωσε ο Frankovsky. “Είναι απλώς θέμα πόσο δουλειά γίνεστε ανά watt ανά δολάριο.«

Το Facebook δεν εικονικοποιεί τους διακομιστές του, επειδή το λογισμικό του καταναλώνει ήδη όλους τους πόρους υλικού, που σημαίνει ότι η εικονικοποίηση θα οδηγούσε σε ποινή απόδοσης χωρίς κέρδος απόδοσης.

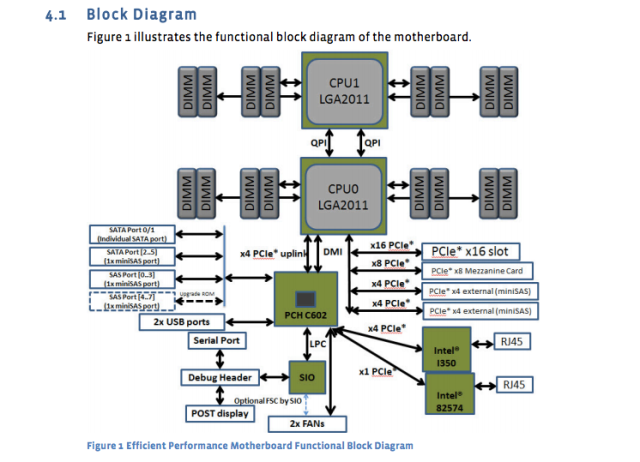

Ο γίγαντας των κοινωνικών μέσων έχει δημοσιεύσει τα σχέδια και τις προδιαγραφές των δικών του διακομιστών, των μητρικών και άλλων εξοπλισμού. Για παράδειγμα, η μητρική πλακέτα “Windmill” χρησιμοποιεί δύο επεξεργαστές Intel Xeon E5-2600, με έως και οκτώ πυρήνες ανά CPU.

Το φύλλο προδιαγραφών του Facebook το σπάει:

- 2 Επεξεργαστές σειράς Intel® Xeon® E5-2600 (LGA2011) έως 115W

- 2 Συνδέσεις Interconnect Interconnect (QPI) έως 8 GT/S/Direction

- Έως 8 πυρήνες ανά CPU (έως και 16 νήματα με τεχνολογία υπερ-σπειρώματος)

- Έως 20 MB τελευταίο επίπεδο προσωρινή μνήμη

- Λειτουργία ενός επεξεργαστή

- DDR3 άμεση στήριξη μνήμης σε CPU0 και CPU1 με:

- 4 καναλιών DDR3 Εγγεγραμμένη διεπαφή μνήμης στους επεξεργαστές 0 και 1

- 2 υποδοχές DDR3 ανά κανάλι ανά επεξεργαστή (σύνολο 16 dimms στη μητρική πλακέτα)

- RDIMM/LV-RDIMM (1.5V/1.35V), LRDIMM και ECC UDIMM/LV-udimm (1.5V/1.35V)

- Μονή, διπλή και quad βαθμολογία DIMMS

- Ταχύτητες DDR3 800/1066/1333/1600 MHz

- Έως και μέγιστη μνήμη 512 GB με 32GB RDIMM DIMMS

Και τώρα ένα διάγραμμα της μητρικής πλακέτας:

Αυτές οι προδιαγραφές της μητρικής πλακέτας δημοσιεύθηκαν σχεδόν πριν από ένα χρόνο, αλλά εξακολουθούν να είναι το πρότυπο. Ο νέος σχεδιασμένος διακομιστής βάσης δεδομένων “Dragonstone” και ο διακομιστής ιστού “Winterfell” βασίζονται στη μητρική πλακέτα ανεμόμυλου, αν και οι νεότερες CPUs Intel θα μπορούσαν να χτυπήσουν την παραγωγή στο Facebook αργότερα φέτος.

Τα σχέδια διακομιστή του Facebook είναι προσαρμοσμένα σε διαφορετικές εργασίες. Όπως ανέφερε ο Timothy Prickett Morgan του μητρώου τον περασμένο μήνα, ορισμένες λειτουργίες βάσης δεδομένων στο Facebook απαιτούν πλεονάζουσες τροφοδοτικές, ενώ άλλες εργασίες μπορούν να αντιμετωπιστούν από διακομιστές με πολλούς υπολογιστές που μοιράζονται μία μόνο παροχή ρεύματος.

Τα κέντρα δεδομένων χρησιμοποιούν ένα μείγμα αποθήκευσης flash και παραδοσιακούς δίσκους περιστρεφόμενης. Οι διακομιστές βάσης δεδομένων χρησιμοποιούν όλα τα Flash. Οι διακομιστές ιστού συνήθως έχουν πραγματικά γρήγορες CPU, με σχετικά χαμηλές ποσότητες αποθήκευσης και μνήμης RAM. Το 16GB είναι μια τυπική ποσότητα μνήμης RAM, είπε ο Φράνκοφσκι. Τα τσιπ Intel και AMD έχουν και τα δύο παρουσία στο Facebook Gear.

Και το Facebook επιβαρύνεται με πολλά “ψυχρά αποθήκευσης”, τα πράγματα που γράφτηκαν μία φορά και σπάνια πρόσβαση ξανά. Ακόμη και εκεί, ο Φράνκοφσκι θέλει να χρησιμοποιήσει όλο και περισσότερο το φλας λόγω του ρυθμού αποτυχίας των δίσκων περιστροφής. Με δεκάδες χιλιάδες συσκευές σε λειτουργία, “Δεν θέλουμε οι τεχνικοί να τρέχουν γύρω από την αντικατάσταση σκληρών δίσκων”, είπε.

Το Flash Data Center-Class είναι συνήθως πολύ πιο ακριβό από τους δίσκους που περιστρέφονται, αλλά ο Φράνκοφσκι λέει ότι μπορεί να υπάρχει ένας τρόπος να το αξίζει. “Εάν χρησιμοποιείτε την κλάση του NAND [Flash] σε δίσκους αντίχειρα, οι οποίες συνήθως θεωρούνται σκούπισμα ή θραύσματα NAND, και χρησιμοποιείτε ένα πραγματικά δροσερό είδος αλγόριθμου ελεγκτή για να χαρακτηρίσετε ποια κύτταρα είναι καλά και ποια κύτταρα δεν είναι, θα μπορούσατε ενδεχομένως να δημιουργήσετε ένα πραγματικά υψηλής απόδοσης διάλυμα αποθήκευσης ψυχρής απόδοσης με πολύ χαμηλό κόστος”, είπε.

Λαμβάνοντας ευελιξία στο κέντρο δεδομένων στο άκρο

Ο Frankovsky θέλει τα σχέδια τόσο ευέλικτα ώστε τα μεμονωμένα εξαρτήματα να μπορούν να αντικατασταθούν ως απάντηση στην μεταβαλλόμενη ζήτηση. Μία προσπάθεια κατά μήκος αυτής της γραμμής είναι η νέα προδιαγραφή “ομάδας αγκαλιά” του Facebook για μητρικές πλακέτες, οι οποίες θα μπορούσαν να φιλοξενήσουν επεξεργαστές από πολλούς προμηθευτές. Η AMD και η Intel, καθώς και οι πωλητές ARM Chip Applied Micro και Calxeda, έχουν ήδη δεσμευτεί να υποστηρίξουν αυτά τα συμβούλια με νέα προϊόντα SOC (System On Chip).

Αυτό ήταν ένα από τα πολλά ειδησεογραφικά στοιχεία που βγήκαν από την ανοικτή κορυφή του περασμένου μήνα στη Σάντα Κλάρα, CA. Συνολικά, οι ανακοινώσεις δείχνουν ένα μέλλον στο οποίο οι πελάτες μπορούν να “αναβαθμίσουν μέσω πολλαπλών γενεών επεξεργαστών χωρίς να χρειάζεται να αντικαταστήσουν τις μητρικές πλακέτες ή τη δικτύωση στο Rack”, σημείωσε ο Frankovsky σε μια ανάρτηση ιστολογίου.

Η Calxeda ήρθε με μια πλακέτα διακομιστή με βάση το ARM που μπορεί να γλιστρήσει στο σύστημα αποθήκευσης ανοιχτού θησαυρού του Facebook, κωδικοποιημένο “Knox.”” Μετατρέπει τη συσκευή αποθήκευσης σε διακομιστή αποθήκευσης και εξαλείφει την ανάγκη για ξεχωριστό διακομιστή για τον έλεγχο του σκληρού δίσκου “, δήλωσε ο Frankovsky. (Το Facebook δεν χρησιμοποιεί διακομιστές ARM σήμερα επειδή απαιτεί υποστήριξη 64-bit, αλλά ο Frankovsky λέει ότι “τα πράγματα γίνονται ενδιαφέροντα” στην τεχνολογία ARM.·

Η Intel συνέβαλε επίσης σχέδια για μια επικείμενη τεχνολογία φωτονικής πυριτίου που θα επιτρέψει τις διασυνδέσεις 100GBPS, 10 φορές ταχύτερη από τις συνδέσεις Ethernet Facebook στα κέντρα δεδομένων της σήμερα. Με τη χαμηλή καθυστέρηση που ενεργοποιείται από αυτό το είδος ταχύτητας, οι πελάτες ενδέχεται να είναι σε θέση να διαχωρίσουν τις CPU, το DRAM και την αποθήκευση σε διάφορα μέρη του ράφι και απλώς προσθέτουν ή αφαιρέσουν εξαρτήματα αντί για ολόκληρους διακομιστές όταν χρειάζεται, είπε ο Frankovsky. Σε αυτό το σενάριο, πολλοί οικοδεσπότες θα μπορούσαν να μοιραστούν ένα σύστημα flash, βελτιώνοντας την αποδοτικότητα.

Παρά όλα αυτά τα προσαρμοσμένα σχέδια που προέρχονται από έξω από τον κόσμο του ΚΑΕ, η HP και η Dell δεν μείνουν εντελώς πίσω. Έχουν προσαρμοστεί για να προσπαθήσουν να συλλάβουν ορισμένους πελάτες που θέλουν την ευελιξία των ανοικτών υπολογιστικών σχεδίων. Ένα εκτελεστικό της Dell παρέδωσε ένα από τα βασικά σημεία στη φετινή ανοικτή Compute Summit, και τόσο η HP όσο και η Dell πέρυσι ανακοίνωσαν το “Server και τα σχέδια αποθήκευσης καθαρού φύλλου” που είναι συμβατά με τις προδιαγραφές “Open Rack” του Open Compute Project.

Εκτός από το γεγονός ότι είναι καλό για το Facebook, ο Frankovsky ελπίζει ότι ο Open Compute θα ωφελήσει τους πελάτες του διακομιστή γενικά. Η Fidelity και η Goldman Sachs είναι μεταξύ εκείνων που χρησιμοποιούν προσαρμοσμένα σχέδια συντονισμένα με το φόρτο εργασίας τους ως αποτέλεσμα του ανοικτού υπολογισμού. Οι μικρότεροι πελάτες ενδέχεται να είναι σε θέση να επωφεληθούν επίσης, ακόμη και αν νοικιάσουν χώρο από ένα κέντρο δεδομένων όπου δεν μπορούν να αλλάξουν το σχεδιασμό διακομιστή ή rack, είπε. Θα μπορούσαν “να πάρουν δομικά στοιχεία [του ανοιχτού υπολογισμού] και να τα αναδιαρθρώσουν σε φυσικά σχέδια που ταιριάζουν στις υποδοχές τους”, δήλωσε ο Frankovsky.

“Η βιομηχανία μετατοπίζεται και αλλάζει με καλό τρόπο, υπέρ των καταναλωτών, λόγω του ανοικτού υπολογισμού”, είπε.